NVIDIA自动驾驶:像素级完美感知让自动驾驶汽车更好理解世界

2019-10-29 17:46

任务:

让自动驾驶汽车获得极度精细的感知功能

方法:

全景分割深度神经网络

在自动驾驶汽车看来,世界万物往往以“边界框”的方式呈现。汽车、行人以及停车标志都被整齐地包裹在红色和绿色的矩形中。

但是,在现实世界中,并非所有事物都能够放进“框”里呈现。

对于高度复杂的驾驶场景,例如被锥形交通路标所标记的施工区域,高速公路上放有沙发椅或出现其他道路障碍物,或者一个人正在一个移动的货车上伸手卸货,在这些场景下,如果汽车的感知软件能够提供对周围环境更详细的感知,那么对自动驾驶的安全决策将会大有裨益。

想要获得极度精细的感知,可以通过以像素级精度对图像内容进行分割的方法,我们称之为全景分割。

通过全景分割,图像能够精确被解构成两个维度。在语义内容的维度中,像素代表汽车、行人以及可驾驶的空间;在实例内容维度中,像素代表着相同的汽车以及不同的目标。

规划和控制模块可以借助来自感知系统的全景分割结果更好地为自动驾驶决策提供依据。例如,详细的目标形状和轮廓信息有助于改善目标跟踪,从而为转向和加速提供更准确的输入。它也可以与密集(即像素级)的目标距离估算方法结合使用,以帮助实现一个高分辨率的3D驾驶场景预测。

单个多任务学习型的深度神经网络

NVIDIA借助单个多任务学习型的深度神经网络实现了对摄像头图像的像素级语义和实例分割。这种方法使我们能够训练一个全景分割的深度神经网络,它可以整体而非碎片化地理解驾驶场景。

这种方式也十分高效。在嵌入式NVIDIA DRIVE AGX平台上,只需一个端到端的DNN就能够抓取所有这些丰富的感知信息,同时实现大约每帧5毫秒的推理速度。这比当下高水平的分割方法还要快得多。

此外,借助DRIVE AGX能够同时运行全景分割DNN和许多其他DNN网络以及实时的感知、定位和规划控制软件。

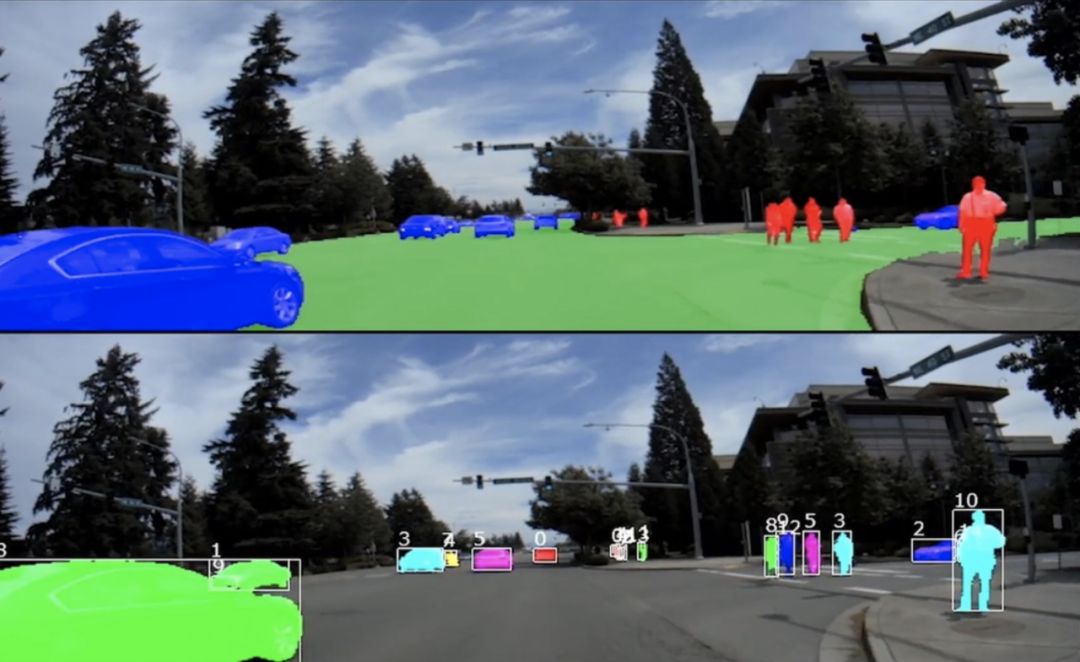

在嵌入式AGX平台上,来自车内推理的全景分割DNN输出。

上图:预测的目标和目标类别(蓝色=汽车;绿色=可驾驶空间;红色=行人)。下图:预测的目标级实例以及包裹在实例外的计算边界框(以不同的颜色和实例ID显示)。

如上图所示,DNN能够将场景划分为几个目标类别,并检测这些目标类别的不同实例,就如同在下面的图中以独特的颜色和数字所示。

相关联的训练和感知

每帧图像中所提供的丰富像素级信息同时也减少了对训练数据量的需求。具体来说,由于每个训练图像都拥有更多的像素,也就提供了更多有用的信息,因此DNN能够使用更少的训练图像进行学习。

此外,基于像素级的检测结果和后处理,我们还能够为每个检测到的目标计算边界框。像素级分割提供的所有感知优势都需要进行处理,这就是我们开发功能强大的NVIDIA DRIVE AGX Xavier的原因。

通过像素级的细节全景分割,自动驾驶汽车可以更好地感知现实世界中丰富的视觉内容,从而做出安全可靠驾驶决策。

分享到微信

分享到微信

分享到微博

分享到微博