ICRA 2019 | NVIDIA宣布最新强化学习研究成果

2019-05-22 09:00

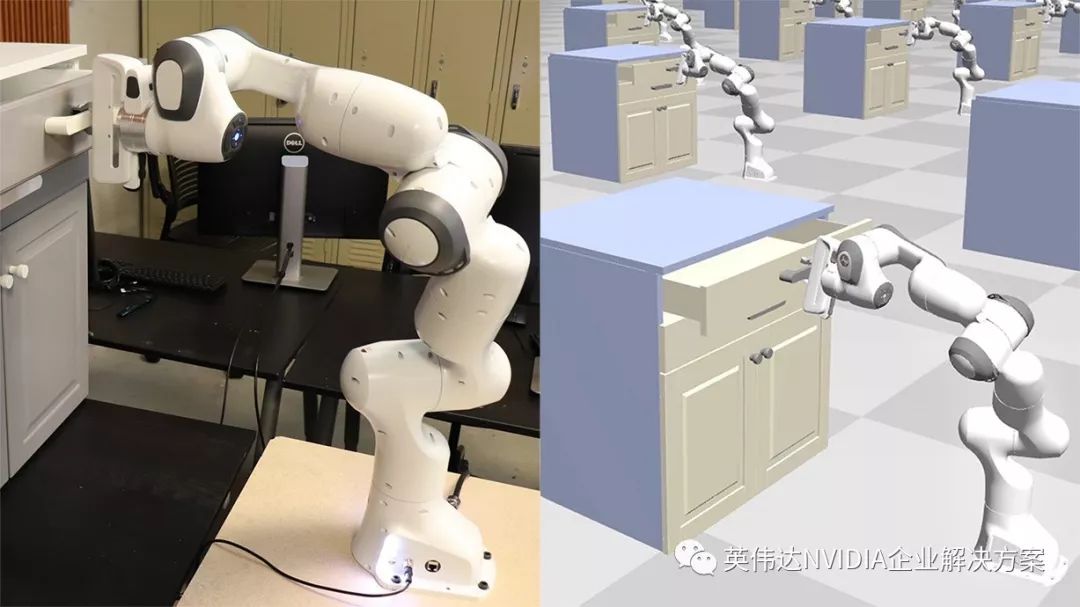

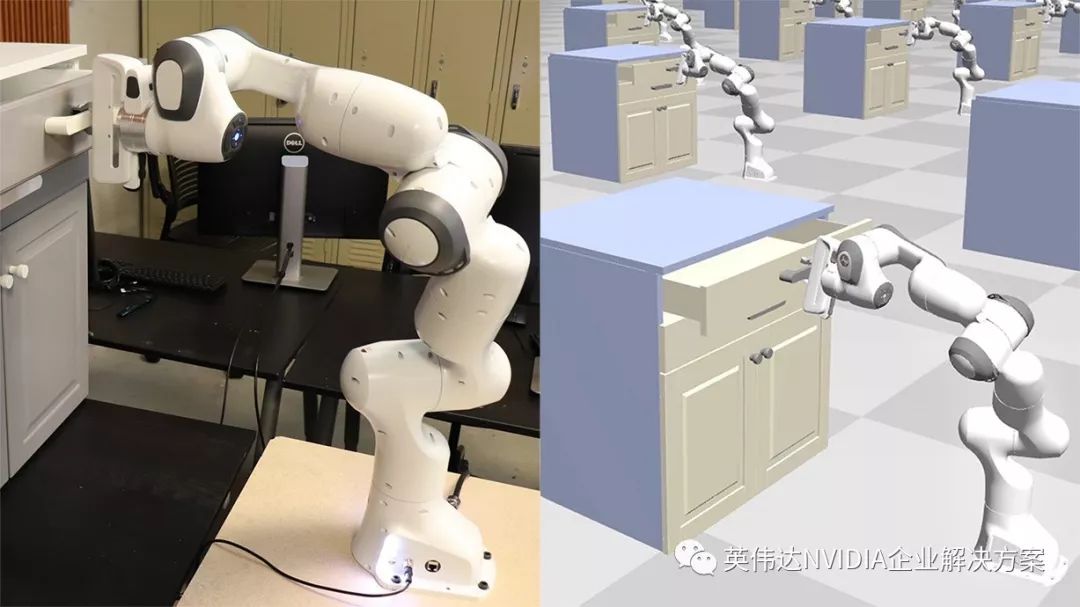

本周,来自华盛顿州西雅图新开设的机器人研究实验室的NVIDIA研究人员正在展示一种新的概念强化学习方法,旨在提高在仿真模拟中训练的机器人在真实世界中的表现。该项成果将在加拿大蒙特利尔举行的国际机器人与自动化会议(ICRA)上发表。

该研究是基于模拟训练的深度学习和机器人社区发展趋势的一部分。由于该方法是虚拟的,因此不存在损坏或伤害的风险,允许机器人在部署到现实世界之前,进行无限次可能地训练。

有一种描述模型训练的方式,是把它比作宇航员在地球上训练如何在太空中执行关键性任务。宇航员学习如何适应太空旅行中的无重力状态,排练并练习任务的各个步骤,学习如何在太空中完美地执行这些复杂的操作。在模拟过程中,强化学习所做的与此类似,只不过是通过机器人来进行的。

“在机器人领域,你通常希望能在模拟中训练,因为你可以涵盖在真实世界中很难获得数据的各种场景,” 该项目的主要研究人员之一Ankur Handa说。 “这项工作背后的想法是训练机器人在模拟器中做一些在现实生活中既单调又耗时的事情,”他解释道。

Handa认为,强化学习机器人社区面临的挑战之一是真实世界和模拟器之间的差异。

研究人员在论文中指出:“由于仿真模型不精确,缺乏对真实世界场景的高保真复制,在模拟中学习到的策略通常不能直接应用于真实世界系统,这一现象也称为现实差距。”

“在这项工作中,我们的重点是通过学习分布在模拟场景上的策略来缩小现实差距,这些模拟场景经过优化能够实现更好的策略迁移。”

“我们并非手动调整模拟的随机化,而是使用与策略训练交错的真实世界的交付来调整模拟参数分布。” Handa说。“我们实际上是在模拟器中创建现实世界的复制品。”

研究人员使用64台NVIDIA Tesla V100 GPU的集群,以及cuDNN加速的TensorFlow深度学习框架,训练机器人执行两项任务:将一个钉子插入孔里,以及打开一个抽屉。

在模拟过程中,团队使用NVIDIA FleX物理引擎来模拟和开发本研究中描述的SimOpt算法。

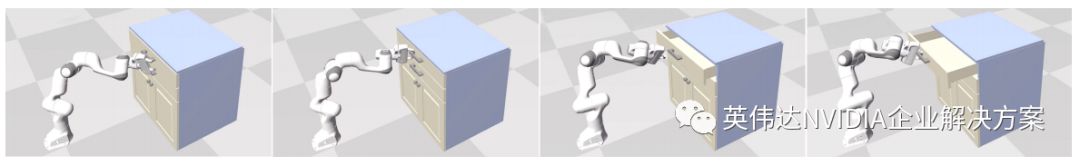

为了完成这两项任务,机器人通过大约1.5-2小时内的超过9600次的模拟进行学习。

目标抽屉开放环境中的策略性能,通过在SimOpt的不同迭代中的随机模拟参数进行训练。随着源环境分布的调整,策略迁移得到改善,直到机器人能够在第四次SimOpt迭代中成功完成任务。

研究人员表示,“将模拟与现实迁移环路相结合,是机器人策略实现强大迁移能力的重要组成部分”。 “在这项工作中,我们证明了使用真实世界数据调整模拟随机化有助于学习模拟参数分布,这些分布特别适合成功的策略迁移,而无需精确复制真实世界环境。”

在SimOpt的不同迭代中运行在模拟训练中的策略,以实现在真实世界里将钉子插孔和抽屉打开的任务。左:SimOpt调整软绳、钉和机器人的物理参数分布,经过两次SimOpt迭代后在真实机器人上成功执行任务。右:SimOpt调整机器人和抽屉的物理参数分布。在更新参数之前,机器人用一个手指在抽屉把手上用力过猛,导致抓取器的手爪打开。经过一次SimOpt迭代后,机器人可以更好地控制其抓取器的方向,从而实现准确地执行任务。

分享到微信

分享到微信

分享到微博

分享到微博