自动驾驶汽车如何“看见”世界?

2019-05-07 09:00

摄像头,雷达和激光雷达传感器让自动驾驶汽车拥有超人般的视觉。

为了比人类驾驶得更好,自动驾驶汽车必须首先拥有比人类更好的视觉。

让自动驾驶汽车拥有可靠的视觉功能一直以来都是技术发展中难以攻破的难题。如今,开发人员可以通过将各种传感器进行组合创建一个监测系统。借助该系统,自动驾驶汽车能够比人类驾驶员更好地“看见”车辆周围环境。

该系统的关键是多样性(即不同类型的传感器)和冗余,重叠的传感器可以验证车辆所检测到的物体是否准确。

三大最主要的自动驾驶汽车传感器是摄像头(camera),雷达(radar)和激光雷达(lidar)。三者协同工作可为车辆提供周围环境的完整视野,并帮助其检测附近物体的速度、距离以及它们的三维形状。

此外,传感器也作为惯性测量单元帮助追踪车辆的加速度和位置。

想要了解这些传感器如何在自动驾驶汽车上工作,代替和改善人类的驾驶视野,就让我们先详细认识一下最常用的传感器 – 摄像头。

摄像头从不说谎

从照片到视频,摄像是将世界可视化的最准确方式,对于自动驾驶汽车来说也尤为重要。

自动驾驶汽车依靠放置在车辆前后左右每一侧的摄像头,将360度的环境视图拼接起来。有些摄像头有较广的视角,高达120度,但所捕捉的视野较近。其他摄像头专注于更窄的视角,以提供较远的视野。

有些汽车上甚至安装了鱼眼摄像头。此类摄像头借助超广镜头可为汽车提供全景视角,让驾驶员在停车时可以获得全景视图从而更好地了解车辆后方环境。

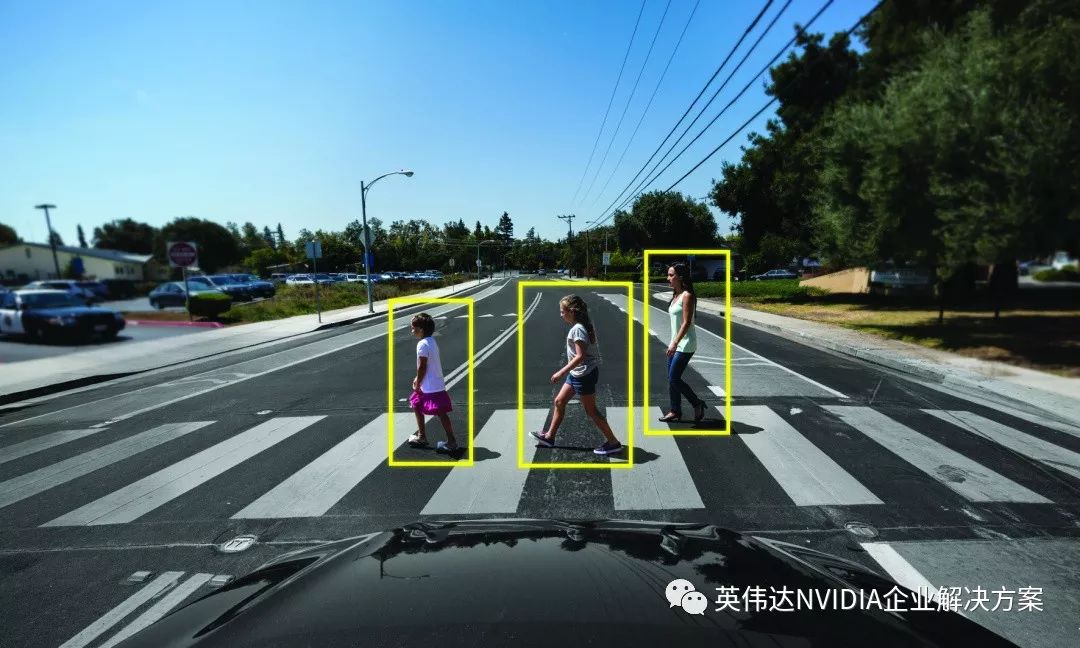

尽管能够提供准确视图,但摄像头也有其局限性。它们虽然可以辨别周围环境的细节,却无法计算出物体与车辆的距离,继而无法准确知道它们的位置。此外,基于摄像头的传感器很难在低能见度的条件下(如雾天,雨天或夜间)检测物体。

这时就需要另外一个传感器的辅助 --- 雷达。

一辆自动驾驶汽车利用摄像头数据感知周围环境的物体。

雷达辅助

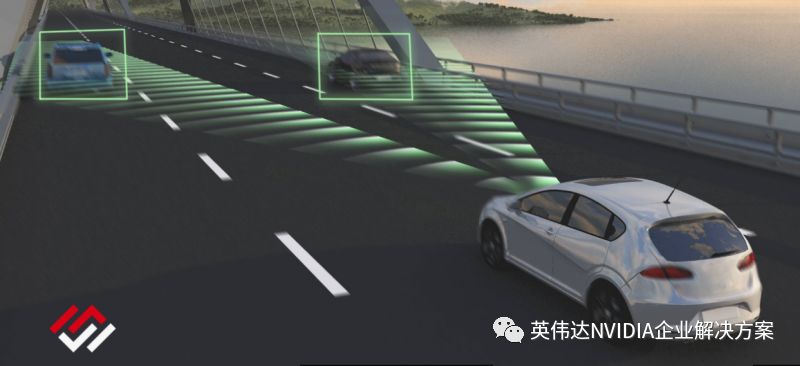

雷达传感器可以在低能见度时(如夜间驾驶)作为摄像头视角的补充,并帮助自动驾驶汽车改善检测功能。

雷达通过脉冲发射无线电波来工作,传统上被应用于检测船只、飞机以及天气状况。一旦这些波击中物体,它们就会返回传感器,并提供有关物体速度和位置的数据。

NVIDIA DRIVE合作伙伴Metawave提供高精度的雷达传感技术。

与车辆上的摄像头一样,雷达传感器通常被布置在汽车周身以检测位于各个角度的物体。它们能够确定物体的速度和距离,但却无法辨别不同类型的车辆。

尽管环绕雷达和摄像头所提供的数据对于较低级的自动驾驶来说已经足够了,但是它们仍然不能在没有人类驾驶员的情况下处理所有的驾驶状况。因此,我们需要激光雷达。

激光聚焦

摄像头和雷达是常见的传感器:如今大多数新车已经将它们用于高级驾驶辅助和停车辅助。 在有人类驾驶员监测系统的情况下,它们还可以实现较低等级的自动驾驶。

然而,如果想要实现完全的无人驾驶,激光雷达的作用不可或缺。

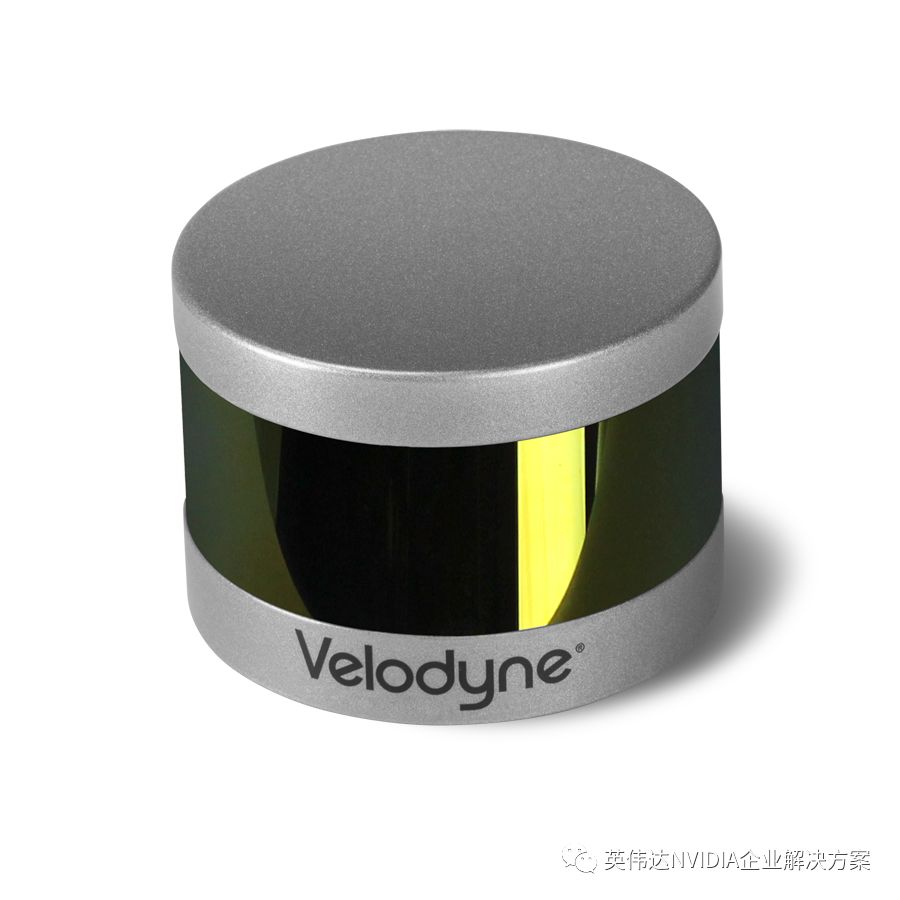

激光雷达是一种通过脉冲激光测量距离的传感器,能够使自动驾驶汽车拥有周边环境的3D视图。它能提供周围汽车及行人的形状和深度,以及道路地理环境。与雷达一样,激光雷达也能在低能见度的环境下运行。

通过以极快的速度发射隐形激光,激光雷达传感器能够根据瞬间反弹的信号绘制出详细的3D图像。 这些信号生成的点云图像代表车辆的周围环境,可以增强传感器数据的安全性和多样性。

Velodyne激光雷达传感器利用激光脉冲检测物体时的视图。

车辆只需要激光雷达在几个关键位置发挥作用。激光雷达传感器的安装成本很高,相当于摄像头和雷达的十倍,而且它的检测范围相对有限。

三大传感器让汽车拥有超人视觉

摄像头,雷达和激光雷达传感器为汽车提供环境相关的丰富数据。然而,如同人类大脑需要处理通过眼睛获得的视觉数据一样,自动驾驶汽车也必须有处理持续信息流的能力。

自动驾驶汽车通过传感器融合来进行数据处理。输入到传感器中的数据被传输到一个高性能集中式的AI计算机当中,比如NVIDIA DRIVE AGX平台。该平台将相关部分的数据结合起来以帮助汽车制定驾驶决策。

所以说,传感器融合不是仅仅依赖于特定时刻的单一类型传感器数据,而是可以融合传感器组所传输的各种信息,比如形状、速度及距离,从而确保可靠性。

传感器还提供冗余功能。在变道之前接收到来自摄像头和雷达传感器的数据能够大大提高驾驶决策的安全性,这就如同当前盲点警告可以作为人类驾驶员的辅助一样。

NVIDIA DRIVE AGX平台在汽车行驶过程中进行该操作流程,所以它始终对车辆周围环境有一个完整且实时更新的视野认知。这就意味着与人类驾驶员不同的是,自动驾驶车辆没有盲点,而且始终对于不断运动和改变的周边环境保持警觉。

分享到微信

分享到微信

分享到微博

分享到微博