NVIDIA Turing 推动 VR 迈向完全沉浸式体验

2018-09-29 17:34

在过去的数十年中,VR 体验不再只是科幻电影的专属,它们已经进入研究实验室,进而走向了家庭和办公室。但是,即便是今天的最佳 VR 体验也尚未实现完全的沉浸感。

NVIDIA 最新推出的 Turing GPU 蓄势待发,有望使 VR 体验朝着这一目标迈进一大步。NVIDIA 在 SIGGRAPH 和科隆游戏展 (Gamescom) 上宣布,Turing 将结合实时光线追踪、AI 和全新渲染技术,推动 VR 技术在沉浸感和逼真度方面再次飞跃。

实时光线追踪

通过引入光线追踪核心 (RT Core),Turing 可达到逼真的视觉保真度。这些处理器专门用于加速光线与环境中物体相交位置的计算,首次在游戏和应用程序中实现了实时光线追踪。

这些光学计算可复制光线的行为方式,从而创造出惊艳无比的逼真画质,让 VR 开发者能够更好地模拟现实世界的环境。

Turing 的 RT Core 还可以利用 NVIDIA VRWorks Audio SDK 进行音频模拟。迄今的 VR 体验可以提供方位精准的音频体验。但它们仍无法满足计算需求,不能充分地反映出环境的空间大小、形状和材质属性,在动态环境中尤甚。

与上一代技术相比,借助 RTX 平台,VRWorks Audio 的运行速度可提高 6 倍。其光线追踪的音频技术能够实时创建虚拟环境的物理逼真声学图像。

在 SIGGRAPH 上,我们演示了 VRWorks Audio 与 NVIDIA Holodeck 的集成,并展示了在开发复杂虚拟环境时,该技术如何创建更为逼真的音效并加速音频工作流程。

由 AI 打造更为逼真的 VR 环境

作为一种 GPU 加速 AI 的方法,深度学习有望能够解决 VR 的最大视觉和感知挑战。图像可以得到进一步增强,位置和眼动追踪可以得到改善,角色动画也可以变得更加生动逼真。

Turing 架构搭载的 Tensor Core 每秒可进行高达 500 万亿张量运算,从而加速推理过程并将 AI 应用于高级渲染技术,使虚拟环境更加逼真。

高级 VR 渲染技术

Turing 还搭载一系列全新渲染功能,可提升 VR 的性能和视觉质量。

可变速率着色 (VRS, Variable Rate Shading) 能够优化渲染。主要方法是在场景的详细区域中应用更多着色性能,并在拥有较少可感知细节的场景中限制计算。这可以降低场景外围区域的着色率(用户不太可能留意的区域,尤其是当与眼动追踪相结合时),从而用于注视点渲染。

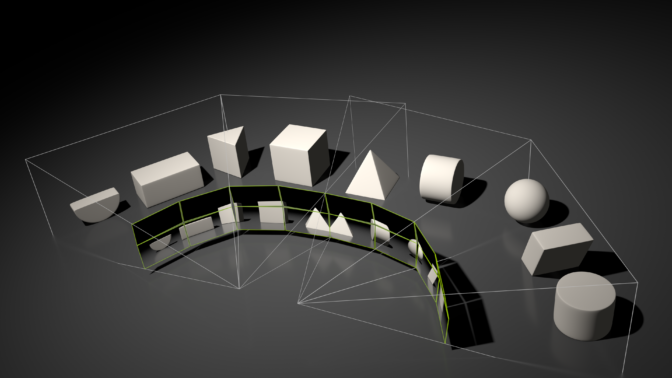

多视图渲染 (Multi-View Rendering)能够支持提供超宽视场和斜面显示屏的下一代头显设备,这样用户就能看到一个无边框的虚拟世界。多视图渲染是单通道立体视觉 (Single Pass Stereo) 的新一代版本,可以将单个渲染通道的投影视图数量增加两倍,达到四张。这四张投影视图现在都独立于位置,并且能够沿任何轴移动。通过渲染四张投影视图,系统可以加速搭载极宽视场的斜面(非共面)头显设备。

Turing 的多视图渲染技术可以加速四张视图的几何处理。

让 VR 连接轻而易举

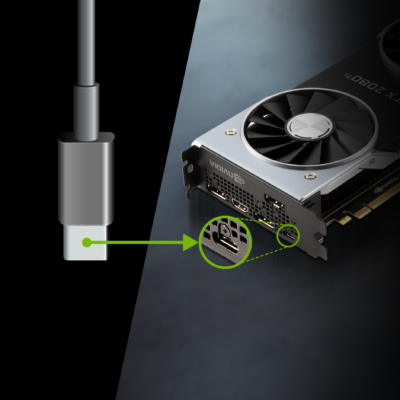

Turing 是 NVIDIA 首款拥有 USB Type-C 和 VirtualLink* 硬件支持的 GPU,其中 VirtualLink 是通过单一的轻量级 USB-C 数据线来驱动新一代 VR 头显设备的全新开放式行业标准。

现在的 VR 头盔在设置上十分复杂,需连接多条笨重的数据线。VirtualLink 通过一根数据线来提供电源、显示和数据,同时可传输大量带宽以满足未来头显设备的需求,从而简化了 VR 的设置过程。单条连接器同时还可以用于将 VR 连接至小型设备,如轻薄型笔记本电脑,后者只提供一个小巧的 USB-C 连接器。

上市情况

开发人员可在 9 月的 VRWorks SDK 更新版中获取 VRWorks Variable Rate Shading、Multi-View Rendering 和 Audio SDK。

NVIDIA 基于 Turing 架构的 Quadro RTX 和 GeForce RTX GPU 将于今年球季在 nvidia.com 网站上发售,也可于领先制造商和插卡合作伙伴处购买。

* 为了兼容最新的 VirtualLink 标准,Turing GPU 已根据 “VirtualLink Advance Overview” 实施了硬件支持。如欲进一步了解 VirtualLink,请访问 www.virtuallink.org。

分享到微信

分享到微信

分享到微博

分享到微博