生成式 AI 研究通过引导式图像结构控制为创作者赋能

2023-07-28 12:58

新的研究正在通过一个文本引导的图像编辑工具来提升生成式 AI 的创造性潜能。这项创新性的研究提出了一个使用即插即用扩散特征(PnP DFs)的框架,可引导实现逼真而精确的图像生成。通过这项研究,视觉内容创作者只需一张提示图片和几个描述性词语,就能将图像转化为视觉内容。

可靠轻松编辑并生成内容的能力有助于艺术家、设计师和创作者不断扩展创意的可能性。这也将为那些依赖动画、视觉设计和图像编辑的行业赋能。

这项研究的首席作者、魏兹曼科学研究院博士研究生 Narek Tumanyan 表示:“最新的文本到图像生成模型标志着数字内容创作进入了一个新时代。然而,将它们应用于现实世界的主要挑战在于缺乏用户可控性,这在很大程度上局限于‘仅通过输入文本来引导图像生成’。我们的工作是最早为用户提供图像布局控制权的方法之一。”

生成式 AI 的最新突破为开发强大的文本到图像模型提供了新方法。然而,复杂性、模糊性以及对定制内容的需求限制了当前渲染技术的发展。

这项研究引入了一种新方法,使用 PnP DFs 来改进图像编辑和生成过程,使创作者对最终产物有更大的控制权。

研究人员从一个简单的问题入手:扩散模型如何表现并捕捉图像的形状或轮廓?研究探索了图像在生成过程中不断演变的内部表征,并研究了这些表征如何对形状和语义信息进行编码。

这种新方法通过理解如何在预训练的文本到图像模型中编码空间信息来控制生成的图像布局,而无需训练新的扩散模型或对其进行微调。在生成过程中,模型从引导图像中提取扩散特征,并将其注入到整个过程中的每一个步骤,从而对新图像的结构进行精细控制。

通过融合这些空间特征,扩散模型可以完善新图像,使其与引导结构相匹配。它会反复进行此过程,更新图像特征,直到生成一张既保留引导图像布局、又与文本提示相匹配的最终图像。

作者写道:“这就产生了一种简单而有效的方法,即从引导图像中提取的特征直接注入到转化图像的生成过程中,无需进行训练或微调。”

这种方法为更先进的可控生成和操作方法铺平了道路。

视频. 在 2023 年国际计算机视觉与模式识别会议(CVPR)上展示的“文本驱动的图像到图像翻译的即插即用扩散特征”研究概述

研究人员使用 cuDNN 加速的 PyTorch 框架在单个 NVIDIA A100 GPU 上开发并测试了这个 PNP 模型。该团队表示,GPU 的大容量使他们能够专注于开发方法。作为 NVIDIA 应用研究加速器计划的参与者,这些研究人员获得了一块 A100 GPU。

该框架部署在 A100 上,能够在大约 50 秒内从引导图像和文本转换为一个新图像。

该过程不仅有高效,而且可靠,能准确地生成令人惊叹的图像。除图像外,它还适用于转化草图、绘图和动画,并能修改照明、色彩和背景。

图 1. 该方法的示例结果,保留了引导折纸图像的结构,同时与目标提示的描述相匹配(来源:Tumanyan, Narek 等人/CVPR 2023)

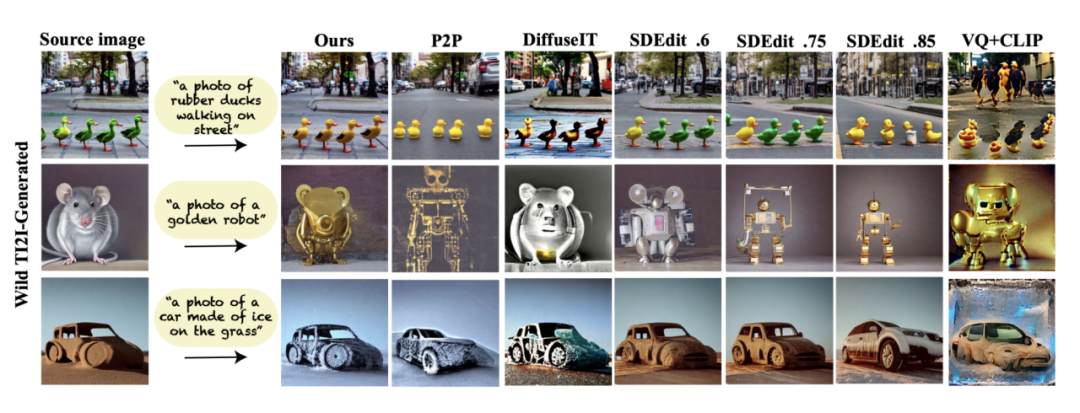

他们的方法还优于现有的文本到图像模型,在保留引导布局和偏离其外观之间实现了卓越的平衡。

图 2. 示例结果,将该模型与 P2P、DiffuseIT、SDedit 和 VQ+CLIP 模型进行三种不同噪声水平的比较(来源:Tumanyan, Narek 等人/CVPR 2023)

然而,该模型确实存在一些局限性。当编辑任意颜色的图像区域时,它的表现并不理想,因为该模型无法从输入图像中提取语义信息。

目前,研究人员正在致力于将这种方法扩展到文本引导的视频编辑中。同时,该研究还证明对于其他利用扩散模型分析图像内部表征的研究也具有重要价值。

例如,有一项研究正在利用该团队的研究成果来改进计算机视觉任务,例如语义点对应。另一项研究则专注于扩展文本到图像生成的控制,包括物体的形状、位置和外观。

这项研究已在 GitHub 上开源。

分享到微信

分享到微信

分享到微博

分享到微博