NVIDIA 支撑自动驾驶车端云端同步迈入高算力大模型时代

2023-03-27 11:51

应用和算力需要相互匹配,并且算力的发展需要一定的超前性以留给算法和应用发展足够的空间。近年来,BEV 和 Transformer 在深度学习领域取得了出色的效果,并带来了很大的效率提升。但同时也对计算量提出了更高的要求,因此出现了一些革命性的技术。

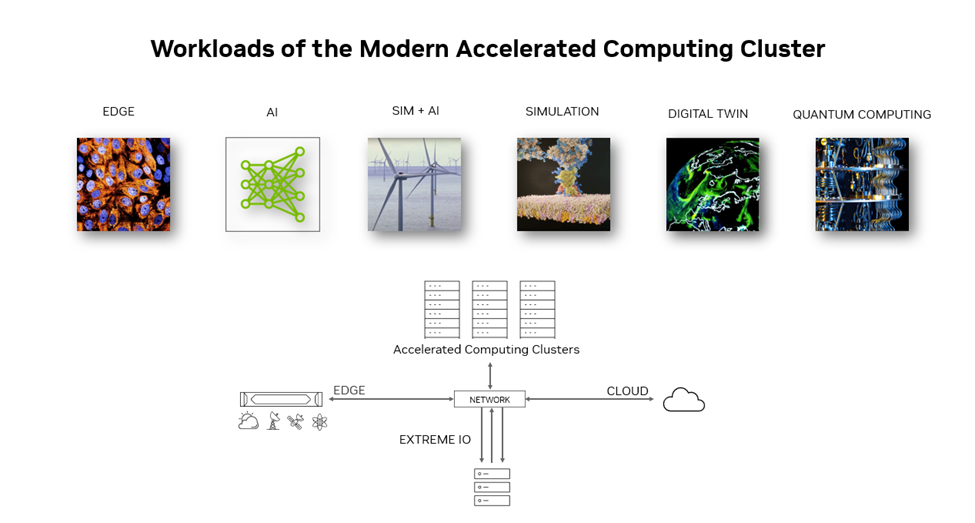

例如 Transformer Engine 和专门做 Transformer block 计算的技术等。除了 BEV 和 Transformer,NVIDIA 也针对各种其它模型,与云服务合作伙伴在云端进行训练和预测加速。对于现代加速的集群,其运行应用类别非常多,包括仿真、AI、scientific AI、数字孪生、量子计算等等,而这些应用都是典型的加速计算集群的应用。

当前,硬件性能提升放缓,每年只有 1.1 倍左右,五年期望的 10 倍提升实际只有 2 倍,十年期望的100倍提升只有 4 倍。此时,如果使用加速计算,每年保持 1.6 倍的提速,将为工作负载提供充足算力,成为应对性能瓶颈的重要解决方案。同时,也需要注意到成本问题,包括单个晶体管价格逐年增加、能源消耗、机房建设、供电等问题,因此需要更多的加速计算来降低成本和提高效率。

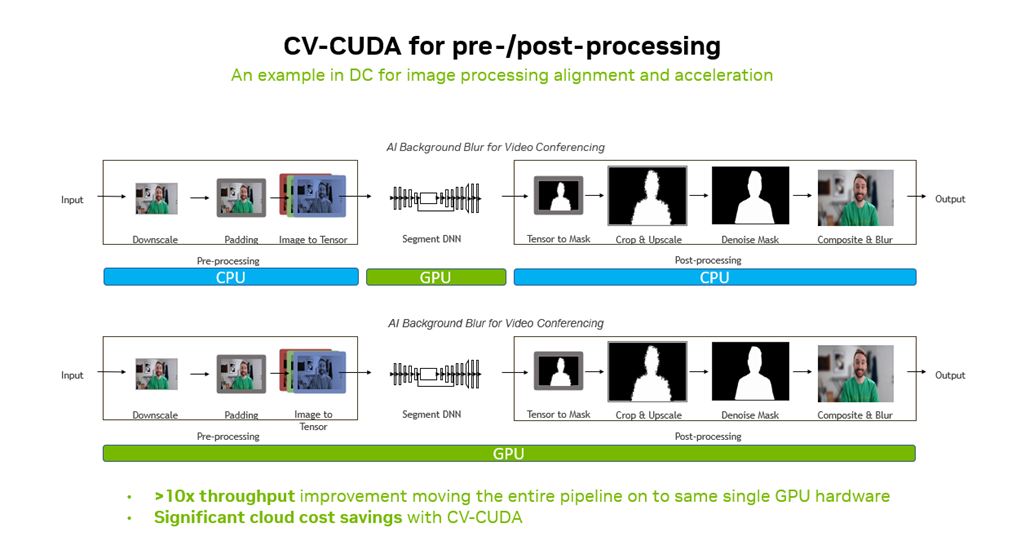

在自动驾驶领域,NVIDIA 能够提供丰富的工具和解决方案,帮助用户完成AI模型端到端的流程。对于数据预处理,NVIDIA 可以提供结构化和非结构化数据的处理工具,还可以进行图像处理,确保训练和预测的一致性。在训练方面,NVIDIA 可以提供不同的框架,同时也会关注模型的推理。在云端部署时,NVIDIA 提供大规模部署的工具。

NVIDIA 相信未来 10 年内,所有计算任务都将被加速,而 NVIDIA 已经为此做好了准备。加速计算的特点和意义在于,可以提高工作效率、降低成本、提升用户体验,同时也推动产业信息化融合的发展。这些特点和意义决定了 NVIDIA 的工作方式,即与客户和合作伙伴深度合作,根据客户需求设计出最适合的解决方案,共同进步。

加速计算需要软硬协同设计,仅依靠单一优化手段,很难达到效果,需要尽可能自上而下得去加速更多环节。AI 的核心是加速,而加速的核心是优化,这需要算法和优化工程师配合完成。

在自动驾驶领域,NVIDIA 将与云服务合作伙伴,依托其他领域的成功经验和成果,为车企和自动驾驶企业,提供端到端的全栈式 AI 加速计算解决方案。

分享到微信

分享到微信

分享到微博

分享到微博