内容介绍

深度神经网络采用两阶段方法来应对激光雷达处理挑战。

自动驾驶实验室

这是NVIDIA DRIVE Labs自动驾驶实验室系列视频的第十八集,在上一集中我们讲了DRIVE Localization如何为自动驾驶汽车指明道路。在自动驾驶实验室系列视频中,我们将以工程技术为重点的视角关注实现自动驾驶汽车的各个挑战以及NVIDIA DRIVE AV软件团队如何应对这些问题。

任务:

为自动驾驶汽车提供丰富视角

方法:

LidarNet DNN

激光雷达可以为自动驾驶汽车提供激光聚焦。

通过从周围环境反射回来的激光信号,激光雷达传感器可以让自动驾驶汽构建出一个详细准确的3D场景,以理解其所处的周围环境。

然而,用于处理激光雷达数据的传统方法面临着重大挑战。其中包括检测和分类不同类型的对象、场景和天气状况的能力,以及性能和可靠性的限制。

在本期的自动驾驶实验室中,我们将介绍LidarNet深度神经网络,该网络借助汽车周围场景的多个视角或视图,以克服传统基于激光雷达处理方法的局限性。

AI赋力的解决方案

将AI融入基于DNN的方式已经成为应对传统激光雷达感知局限性的首选解决方案。

一种AI方法是使用激光雷达DNN在激光雷达点云数据上执行自上至下或“鸟瞰”(BEV)对象检测。首先在场景上方某个高度放置一个虚拟摄像头(类似于头顶飞过的鸟),然后通过正交投影将每个数据点的3D坐标重新投影到该虚拟摄像头的视图中。

鸟瞰激光雷达DNN在其图层中使用2D卷积来检测动态对象,例如汽车、卡车、公共汽车、行人、骑自行车的人和其他道路使用者。2D卷积运行速度很快,因此非常适合在实时自动驾驶应用中使用。

但是,当检测对象的运动仿佛自上而下时,此方法可能会遇到障碍。例如,在鸟瞰图中,行人或自行车可能看起来像电线杆、树干或灌木丛之类的物体,从而导致感知错误。

另一种AI方法使用3D激光雷达点云数据作为DNN的输入,该DNN在其图层中使用3D卷积来检测对象。当DNN用3D形状检测目标对象时可以提高准确性。但是,激光雷达点云的3D卷积DNN处理不太适用于实时自动驾驶应用。

拥有多视角的LidarNet

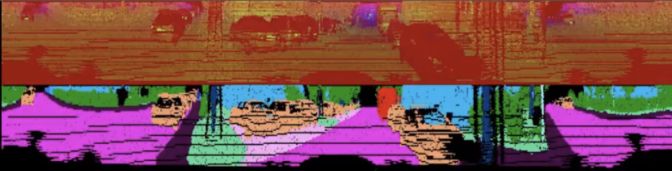

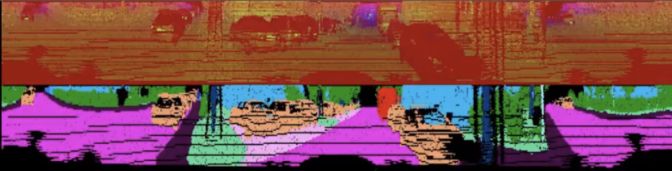

为了克服这两种基于AI方法的局限性,我们开发了多视角LidarNet深度神经网络。该方法分为两个阶段,第一阶段使用透视图中的激光雷达扫描数据提取相关场景的语义信息(图1)。也就是通过“展开” 360度环绕激光雷达扫描,让整个全景图展现在自动驾驶汽车面前。

图1:多视角LidarNet视角示意

第一阶段的语义分割方法在预测对象类别方面表现颇佳。这是因为DNN可以更好地在透视图中观察对象的形状(例如,行走的人的形状)。

第一阶段还将场景分为不同类别的动态对象,例如汽车、卡车、公共汽车、行人、骑自行车的人和摩托车手,以及静态道路场景元素,例如路面、人行道、建筑物、树木和交通标志。

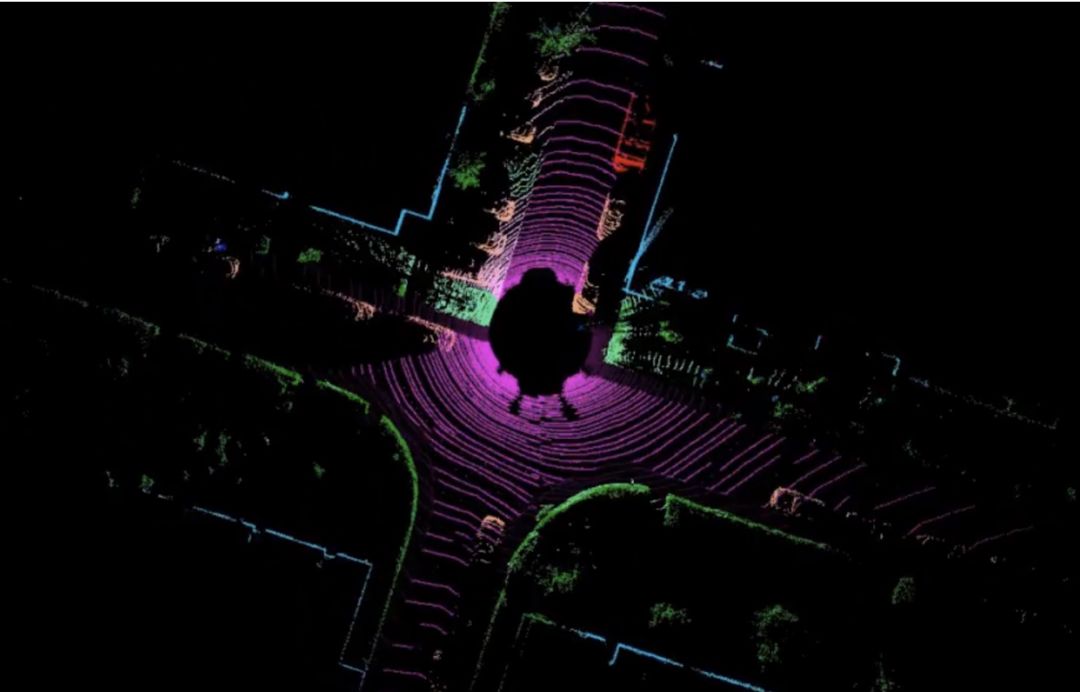

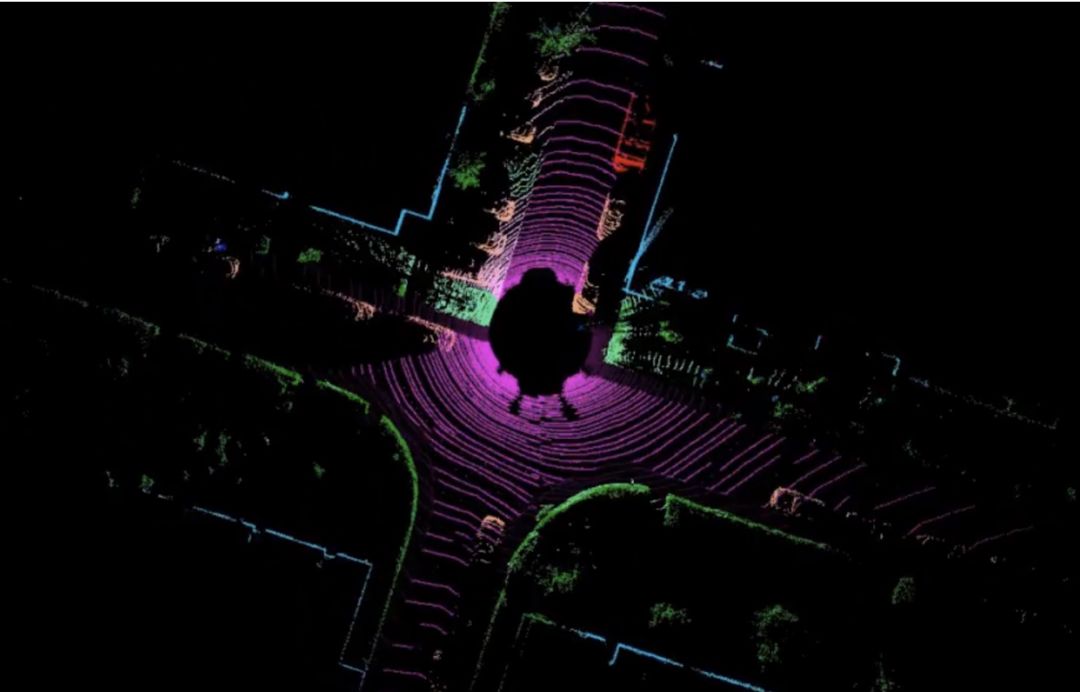

然后,将激光雷达网络第一阶段生成的语义分段输出投射到鸟瞰图中,并与从激光雷达点云中获得的每个位置的高度数据进行组合。这一过程所产生的输出将用作第二阶段的输入(图2)。

图2:多视角LidarNet自上至下鸟瞰图示意(BEV)

第二阶段中,DNN在带有鸟瞰图标签的数据上进行训练,以预测第一阶段标识的对象周围自上而下的2D边界框。此阶段还使用语义和高度信息来提取对象实例。该阶段在鸟瞰图中更容易实现,因为在图中的对象不会相互遮挡。

将这两个阶段链接在一起,得到一个仅处理一个激光雷达数据的激光雷达DNN。它使用端到端深度学习来输出丰富的场景语义分割,并带有检测对象的2D边界框。

通过这种方法,该DNN能够高精度且完整地检测出易受伤害的道路使用者,例如摩托车手、自行车手和行人。此外,该DNN能够实现高效处理,在NVIDIA DRIVE™ AGX平台上,每次激光雷达扫描的推理时间仅需7毫秒。

除了多视角LidarNet,我们的激光雷达处理软件堆栈还包括一个激光雷达对象追踪器。该追踪器基于计算机视觉的后处理系统,它使用鸟瞰图2D边界框信息和激光雷达点几何图为每个对象实例计算3D边界框。它还可以帮助稳定每帧DNN的错误检测,并与低级激光雷达处理器一起,计算汽车应避免的严格物理边界的几何围栏。

AI和传统计算机视觉方法的结合提高了NVIDIA激光雷达感知软件堆栈的稳定性。此外,由激光雷达感知提供的丰富感知信息可以与摄像头和雷达检测相结合,以构建出更强大的L4级到L5级自动驾驶系统。

自动驾驶实验室

这是NVIDIA DRIVE Labs自动驾驶实验室系列视频的第十八集,在上一集中我们讲了DRIVE Localization如何为自动驾驶汽车指明道路。在自动驾驶实验室系列视频中,我们将以工程技术为重点的视角关注实现自动驾驶汽车的各个挑战以及NVIDIA DRIVE AV软件团队如何应对这些问题。

任务:

为自动驾驶汽车提供丰富视角

方法:

LidarNet DNN

激光雷达可以为自动驾驶汽车提供激光聚焦。

通过从周围环境反射回来的激光信号,激光雷达传感器可以让自动驾驶汽构建出一个详细准确的3D场景,以理解其所处的周围环境。

然而,用于处理激光雷达数据的传统方法面临着重大挑战。其中包括检测和分类不同类型的对象、场景和天气状况的能力,以及性能和可靠性的限制。

在本期的自动驾驶实验室中,我们将介绍LidarNet深度神经网络,该网络借助汽车周围场景的多个视角或视图,以克服传统基于激光雷达处理方法的局限性。

AI赋力的解决方案

将AI融入基于DNN的方式已经成为应对传统激光雷达感知局限性的首选解决方案。

一种AI方法是使用激光雷达DNN在激光雷达点云数据上执行自上至下或“鸟瞰”(BEV)对象检测。首先在场景上方某个高度放置一个虚拟摄像头(类似于头顶飞过的鸟),然后通过正交投影将每个数据点的3D坐标重新投影到该虚拟摄像头的视图中。

鸟瞰激光雷达DNN在其图层中使用2D卷积来检测动态对象,例如汽车、卡车、公共汽车、行人、骑自行车的人和其他道路使用者。2D卷积运行速度很快,因此非常适合在实时自动驾驶应用中使用。

但是,当检测对象的运动仿佛自上而下时,此方法可能会遇到障碍。例如,在鸟瞰图中,行人或自行车可能看起来像电线杆、树干或灌木丛之类的物体,从而导致感知错误。

另一种AI方法使用3D激光雷达点云数据作为DNN的输入,该DNN在其图层中使用3D卷积来检测对象。当DNN用3D形状检测目标对象时可以提高准确性。但是,激光雷达点云的3D卷积DNN处理不太适用于实时自动驾驶应用。

拥有多视角的LidarNet

为了克服这两种基于AI方法的局限性,我们开发了多视角LidarNet深度神经网络。该方法分为两个阶段,第一阶段使用透视图中的激光雷达扫描数据提取相关场景的语义信息(图1)。也就是通过“展开” 360度环绕激光雷达扫描,让整个全景图展现在自动驾驶汽车面前。

图1:多视角LidarNet视角示意

第一阶段的语义分割方法在预测对象类别方面表现颇佳。这是因为DNN可以更好地在透视图中观察对象的形状(例如,行走的人的形状)。

第一阶段还将场景分为不同类别的动态对象,例如汽车、卡车、公共汽车、行人、骑自行车的人和摩托车手,以及静态道路场景元素,例如路面、人行道、建筑物、树木和交通标志。

然后,将激光雷达网络第一阶段生成的语义分段输出投射到鸟瞰图中,并与从激光雷达点云中获得的每个位置的高度数据进行组合。这一过程所产生的输出将用作第二阶段的输入(图2)。

图2:多视角LidarNet自上至下鸟瞰图示意(BEV)

第二阶段中,DNN在带有鸟瞰图标签的数据上进行训练,以预测第一阶段标识的对象周围自上而下的2D边界框。此阶段还使用语义和高度信息来提取对象实例。该阶段在鸟瞰图中更容易实现,因为在图中的对象不会相互遮挡。

将这两个阶段链接在一起,得到一个仅处理一个激光雷达数据的激光雷达DNN。它使用端到端深度学习来输出丰富的场景语义分割,并带有检测对象的2D边界框。

通过这种方法,该DNN能够高精度且完整地检测出易受伤害的道路使用者,例如摩托车手、自行车手和行人。此外,该DNN能够实现高效处理,在NVIDIA DRIVE™ AGX平台上,每次激光雷达扫描的推理时间仅需7毫秒。

除了多视角LidarNet,我们的激光雷达处理软件堆栈还包括一个激光雷达对象追踪器。该追踪器基于计算机视觉的后处理系统,它使用鸟瞰图2D边界框信息和激光雷达点几何图为每个对象实例计算3D边界框。它还可以帮助稳定每帧DNN的错误检测,并与低级激光雷达处理器一起,计算汽车应避免的严格物理边界的几何围栏。

AI和传统计算机视觉方法的结合提高了NVIDIA激光雷达感知软件堆栈的稳定性。此外,由激光雷达感知提供的丰富感知信息可以与摄像头和雷达检测相结合,以构建出更强大的L4级到L5级自动驾驶系统。

订阅英伟达 NVIDIA 技术月刊

分享到微信

分享到微信

分享到微博

分享到微博