NGC赋能翼展医疗互联网+医学影像平台 助推医疗资源均衡化

2019-01-17 09:00

医学影像人工智能协作平台,基于NVIDIA GPU Cloud (NGC) 的远程医学影像诊断平台,使高精度远程诊疗成为现实,帮助逐步实现医疗资源均衡化。

“互联网+医学影像”

AI助推实现医疗资源均衡化

目前,我国公共医疗资源分配不均,大型医院医疗资源紧张,同时小型医院医疗资源又未得到充分发挥。分级诊疗是医疗资源均衡化的一个突破口,通过整合医疗服务的需求入口,使各级医疗服务机构能够更好地发挥自身价值,提高医疗体系的整体服务效率。

在就诊过程中,医学影像结论有着重要的作用,而AI 辅助影像诊断可以有效地提升医疗资源运转效率;此外,医学影像极具互联网基因,在人工智能提升医疗能力的过程中,将首先推进实现分级诊疗。

翼展医疗集团是一家提供智慧医学影像解决方案的专业医疗机构,同时也是一家专注于医学影像人工智能应用研发的高科技企业。翼展医疗集团通过建立人工智能开放协作平台、在线云诊断平台、翼展医学影像诊断中心、影像医生集团、多病种早筛中心,打造了行业独有的多维生态进化体系,使高精度远程诊疗成为现实,逐步帮助医疗资源均衡化。借助NVIDIA GPU Cloud (NGC),翼展医疗集团解决了其在平台建立之初遭遇的深度学习团队机时分配困难和平台兼容性较差等问题,使其平台变得更加灵活,且具备强大的兼容性,能够易于部署及运维人工智能应用产品。

从平台建立到运维 翼展遭遇重重挑战

为了更好地落地AI产品,贴近临床,翼展医疗集团打造了人工智能开放协作平台,为人工智能企业和创业团队提供人工智能产品的发布和搭建平台,在云诊断平台集成各病种AI诊断工具,主要分为高端筛查及专项筛查两个方向;同时,通过建立人工智能开放协作平台、在线云诊断平台、翼展医学影像诊断中心、影像医生集团、多病种早筛中心,打造了行业独有的多维生态进化体系,为人工智能产品提供了充足的落地应用场景,使其更加贴近临床,更好地服务于医生和患者,使高精度远程诊疗成为现实,逐步帮助医疗资源均衡化。

然而,在平台搭建之初,翼展医疗集团遭遇了诸多挑战。

从头搭建机器学习平台——费时费力

2016年,翼展开始进行医学影像人工智能应用的研发。由于当时公有云厂商能够提供GPU实例的还非常少,于是翼展选择自行采购硬件设备搭建服务器。其首先配置了一台双卡工作站,按照网上教程一步步安装ubuntu,NVIDIA GPU驱动程序,CUDA,cuDNN,但最后编译Caffe的时候发现库版本不对,只能从头配置,花费了一周左右的时间才开始正式训练模型。之后,翼展升级了服务器,采用由第三方厂商配置好操作系统和底层驱动的8卡服务器,但随着内部团队成员的增加,新的问题又随之而来。

机器学习团队需求各不同,机时分配遇窘境

起初,翼展团队中只有一名专职深度学习专家,可以在双卡工作站做小批量数据预训练,然后在服务器上做大规模训练,本地和远程环境可以设置成一样的。但随着团队成员的增加,就开始需要分配训练机时了。由于每个人的项目不同,使用的模型不同,底层依赖的深度学习框架及库版本也不同,一个统一的完全没有隔离的环境越来越不能满足日常训练的要求。曾经出现过的事故是,有模型需要将Python版本升级,升级之后导致其他人的模型无法正常工作。

翼展采取了严格的规章制度,划分用户空间,每个人需要的 Python执行环境、深度学习框架及第三方库都自行安装在各自的用户空间。对于GPU驱动程序及CUDA等底层库,则只能由管理员来进行安装和升级。升级前还须要做好兼容性测试,一旦不同用户的模型有冲突便难以解决。后来随着开始租用公有云的GPU实例,情况得到了一定程度的好转,不过在公有云上安装配置环境依然费时费力。

深度学习模型多种多样,平台难以招架

2017年,翼展开始布局人工智能开放协作平台,为人工智能企业和创业团队提供医学影像人工智能产品发布和运行平台。该平台需要接入不同厂商的产品,有的产品是通过API接入,后台深度学习模型的运行环境由厂商自行维护;有的则是厂商直接将模型发布给翼展,由其提供运行时环境,并且模型的迭代速度很快,新版本模型底层依赖版本也会相应变化,每次升级的操作都不只是简单地部署一个新模型,还需要同时将运行时环境一并升级,而且工程团队通常至少需要同时维护一套测试环境和生产环境。虽然当时工程团队已经采用了DevOps,有了Docker的运维经验,但是管理GPU云上实例及各种机器学习框架不同版本仍然是一个巨大的挑战——直到NGC的出现。

“2017年翼展开始布局医学影像人工智能开放协作平台后,我们需要部署的机器学习应用越来越多,手工方式的落后管理必然要被工程化管理所取代。虽然这个时候工程团队已经拥抱DevOps,有了Docker的运维经验,不过管理 GPU云上实例及各种机器学习框架不同版本仍然是一个噩梦…直到NGC的出现。”

--- 边海锋 翼展医疗集团 CTO

“NGC提供流行常用的第三方兼容GPU、符合NGC标准和最佳实践的高性能计算应用容器,使用户可以方便的在最短的时间内启动和运行起来。这正是我们一直在寻找的东西。看到这个介绍的吋候,我们第一时间在NGC网站进行了注册,并且很快在自己的服务器上pull了一个NGC容器试用,发现真的非常简单。”

--- 谢锋波 翼展医疗集团 高级研发总监

NGC带来简单高效的解决方案

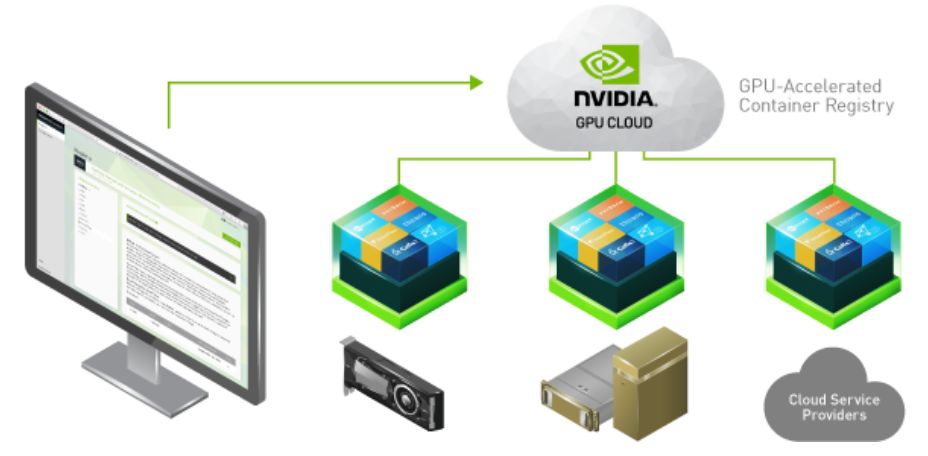

NVIDIA GPU Cloud (NGC)是针对深度学习和科学计算优化的基于GPU加速的云平台。在当前的发行版本中,NGC包含了NGC容器,NGC容器注册,NGC网站,以及用以运行深度学习容器的平台软件。

NGC容器旨在提供一个软件平台,该平台基于最小的操作系统要求、安装在服务器或工作站上Docker和驱动,通过NGC容器注册里的NGC容器提供所有的应用程序和SDK软件。

NGC管理着一份目录,包含了完全集成和优化的深度学习框架容器,适用于单GPU以及多GPU配置环境。这些容器包括:CUDA工具包,DIGITS工作流,以及以下深度学习框架:NVCaffe, Caffe2, Microsoft Cognitive Toolkit (CNTK), MXNet, PyTorch, TensorFlow, Theano 和 Torch。这些框架容器以开箱即可用的方式交付,包含了所有必须的依赖,比如CUDA运行时环境、 NVIDIA库和运行系统环境。每个框架容器镜像还包含了框架源代码,以支持用户自定义修改和增强功能,以及完整的软件开发栈。

NGC也提供流行常用的第三方兼容GPU、符合NGC标准和最佳实践的高性能计算应用容器,使用户可以方便的在最短的时间内启动和运行起来。基于NGC,工程师们能够快速启动应用开发程序,使应用程序尽早开始运行,减少了通常与设置软件相关的复杂性以往需要几周的工作,现在几分钟就可以解决。

NVIDIA每月对这些深度学习的容器进行更新,以确保提供最佳性能。在深度学习框架容器的基础上,NGC也提供了一系列高性能计算可视化应用容器,采用支持业界领先的可视化工具,包括集成了NVIDIA Index 立体渲染的ParaView, NVIDIA OptiX 光线追踪库和NVIDIA Holodeck,以实现高质量可交互的实时视觉效果。

NGC既可以在自建服务器上使用,也可以在其他公有云上使用。如今有新的合作伙伴加入申请机器学习训练环境,或者新的项目要启动,亦或新的模型要部署,翼展医疗集团的运维工程师只需对方告知其深度学习框架的版本,然后在NGC网站找到对应的镜像,运行一个docker pull命令,然后就可以悠闲的去喝杯咖啡了。

翼展医疗集团如今正在做的事情,是利用NGC的自定义容器功能,将自研的深度学习应用发布为 NVIDIA-docker镜像,这样可以进一步简化应用部署,同时可以与工程团队其他项目共用一套持续集成及运维的流程。

目前翼展的医学影像人工智能协作平台已上线十余种人工智能产品,包括用于血管壁分割及斑块成分分析的磁共振斑块成像解决方案、CT下肺结节筛查、DR胸肺常见疾病筛查、DR智能报告自动生成系统等,为合作医院及各类医疗机构提供了有力的支撑,促进诊断能力提升。

分享到微信

分享到微信

分享到微博

分享到微博