谷歌云与 NVIDIA 进一步深化合作

2023-10-08 17:37

两家 AI 领军企业一同优化谷歌云,使更多生成式 AI 领域的初创企业能够构建下一代应用。

生成式 AI 和大语言模型(LLM)不断推动创新,使训练和推理工作的算力需求以惊人的速度增长。

为了满足这一需求,谷歌云近日宣布全面推出由 NVIDIA H100 Tensor Core GPU 驱动的全新 A3 实例。NVIDIA H100 Tensor Core GPU 通过专为加速大语言模型(LLM)而构建的 Transformer 引擎,为各种 AI 应用带来了前所未有的性能。

就在谷歌推出这些 A3 实例前,NVIDIA 被评为谷歌云年度生成式 AI 合作伙伴,表彰两家公司在加速谷歌云上的生成式 AI 方面所开展的深入、持续合作。

从基础设施的设计到广泛的软件支持,双方采取了多种合作形式,使在谷歌云平台上构建和部署 AI 应用变得更加容易。

在 Google Cloud Next 大会上,NVIDIA 创始人兼首席执行官黄仁勋参与了谷歌云首席执行官 Thomas Kurian 的主题演讲,共同庆祝由 NVIDIA H100 GPU 驱动的 A3 实例将全面上市,并介绍了谷歌是如何将 NVIDIA H100 和 A100 GPU 用于 DeepMind 和其他部门的内部研究与推理的。

在讨论中,黄仁勋谈到了双方更深层次的合作,使用 NVIDIA GPU 加速用于创建大规模大语言模型(LLM)的 PaxML 框架。这个基于 Jax 的机器学习框架专为训练大规模模型而设计,可实现先进、完全可配置的实验与并行化。

PaxML 已被谷歌用于构建内部模型,包括 DeepMind 以及各研究项目,并且该框架将使用 NVIDIA GPU。两家公司还宣布在 NVIDIA NGC 容器注册表上将即刻提供 PaxML。

生成式 AI 初创企业不断涌现

如今,有 1,000 多家生成式 AI 初创企业正在构建下一代应用,其中许多企业都在谷歌云上使用 NVIDIA 技术,比较著名的有 Writer 和 Runway。

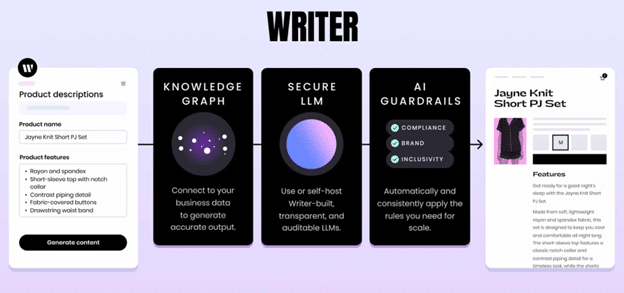

Writer 使用基于 Transformer 的大语言模型(LLM)帮助营销团队快速创建网页、博客、广告等文案。为此,该公司使用了 NVIDIA NeMo。这个来自 NVIDIA AI Enterprise 的应用框架可帮助企业整理训练数据集、构建和自定义大语言模型(LLM),并在生产中大规模运行。

Writer 的开发人员原本只能使用亿级参数模型,而通过 NeMo 进行优化,他们现在能够处理拥有 400 亿个参数的模型。这家初创企业的客户包括德勤、欧莱雅、财捷集团、优步等家喻户晓的财富 500 强企业。

Runway 使用 AI 生成各种风格的视频。该 AI 模型会根据给定图片或文本提示模仿特定风格。通过该模型,用户还可以使用现有素材创建新的视频内容。这种灵活的创作模式使电影制作人和内容创作者能够以全新的方式探索和设计视频。

谷歌云是首家将 NVIDIA L4 GPU 带到云上的云服务提供商(CSP)。两家公司还一同使谷歌的 Dataproc 服务能够利用 Apache Spark 的 RAPIDS 加速器大幅提升 ETL 的性能。这项功能目前与谷歌计算引擎上的 Dataproc 一同提供,不久后还可通过 Serverless Dataproc 获得。

两家公司还在谷歌云市场提供 NVIDIA AI Enterprise,并将 NVIDIA 加速软件集成到 Vertex AI 开发环境中。

欢迎访问相关页面,以了解谷歌云上关于 NVIDIA GPU 实例和 NVIDIA 如何推动生成式 AI 发展的更多详情:

谷歌云上的 NVIDIA GPU 实例:https://cloud.google.com/gpu/

NVIDIA 如何推动生成式 AI 发展:https://www.nvidia.cn/ai-data-science/generative-ai/

分享到微信

分享到微信

分享到微博

分享到微博