NVIDIA 极致性能赋能飞桨落地千行百业

2022-12-26 13:44

11 月 30 日,由深度学习技术及应用国家工程研究中心主办、百度飞桨承办的 WAVE SUMMIT+ 2022 深度学习开发者峰会圆满落幕。

本次峰会上,百度 AI 技术生态总经理马艳军发布了飞桨开源框架 2.4 版本,并携手 NVIDIA 等 12 家生态伙伴发布了飞桨生态发行版,为开发者提供更好的软硬一体化体验。

作为飞桨的深度合作伙伴,NVIDIA 也出席了这场盛大的线上峰会。NVIDIA 亚太区资深产品负责人 Adam Zheng 还带来了以“NVIDIA 全新一代产品,极致性能赋能飞桨落地千行百业”为主题的分享。以下为内容概要。

NVIDIA 推出 Hopper 架构

NVIDIA 作为计算加速行业的领导者,正在通过全栈创新推动高性能计算的发展。从芯片和系统,到它们运行的算法和应用程序,NVIDIA 平台将 AI 带入了全球最大的行业,提供包括推荐系统、AR、VR、自动驾驶汽车等解决方案,并加速科学研究。

今年春季 GTC 大会上,NVIDIA 发布了 Hopper 全新一代 GPU 架构,提供了六项突破性创新(如上图):

一、世界上最先进的芯片。由 800 亿个晶体管构建而成,这些晶体管采用了专为 NVIDIA 加速计算需求设计的尖端的 TSMC 4N 工艺,因而能够显著提升 AI、HPC、显存带宽、互连和通信的速度,并能够实现近 5TB/s 的外部互联带宽。此外,该款芯片也是首款支持 PCIe 5.0 的 GPU,也是首款采用 HBM3 的 GPU,可实现 3TB/s 的显存带宽。20 个芯片便可承载相当于全球互联网的流量,使其能够帮助客户推出先进的推荐系统以及实时运行数据推理的大型语言模型。

二、新的 Transformer 引擎——Transformer 现在已成为自然语言处理的标准模型方案,也是深度学习模型领域最重要的模型之一。新的 Transformer 引擎,可以将这些网络的速度提升至上一代的六倍,而不会损失精度。

三、第二代安全多实例 GPU —— MIG 技术支持将单个 GPU 分为七个更小且完全隔离的实例,以处理不同类型的作业。与上一代产品相比,在云环境中 Hopper 架构通过为每个 GPU 实例提供安全的多租户配置。

四、机密计算——全球首款具有机密计算功能的加速器,可保护 AI 模型和正在处理的客户数据。客户还可以将机密计算应用于医疗健康和金融服务等隐私敏感型行业的学习,也可以应用于共享云基础设施。

五、第 4 代 NVIDIA NVLink——为加速大型 AI 模型,NVLink 结合全新的外接 NVLink Switch,可将 NVLink 扩展为服务器间的互联网络。相比上一代 HDR Quantum InfiniBand,实现 9 倍的速度提升,并可连接多达 256 个 GPU。

六、DPX 指令——新的 DPX 指令可加速动态规划,适用于包括路径优化和基因组学在内的一系列算法,与 CPU 和上一代 GPU 相比,其速度提升分别可达 40 倍和 7 倍。

AI 开发只有顶尖的芯片是不够的,还需要软硬全栈和广阔的生态。NVIDIA 提供端到端的 AI 软件套件,覆盖数据准备、训练、推理优化到大规模部署等多个环节,以强大的资源调度和管理能力助力客户加速 AI 开发与部署。

NVIDIA 在加速计算领域的沉淀,以及其全新一代产品,为赋能飞桨生态奠定了基础。

NVIDIA 携手百度飞桨

加速 535 万开发者的 AI 进程

百度飞桨是中国首个自主研发、功能丰富、开源开放的产业级深度学习平台。近年来,飞桨的技术实力深受广大硬件厂商认可,合作日趋紧密,软硬一体协同发展,生态共创硕果累累。

NVIDIA 非常重视中国市场,特别关注中国的生态伙伴,而当前飞桨拥有 535 万的开发者。过去的几年中,NVIDIA 与飞桨一直保持着深度全面的合作关系。双方一起做了大量的开发与优化工作。

今年我们将飞桨列为 NVIDIA 全球前三的深度学习框架合作伙伴,在中国设立了专门的工程团队支持,赋能飞桨。关于 NVIDIA 与飞桨的合作,由于篇幅原因,我们仅从硬件适配的角度,沿用上图的四个阶段做一个简要的介绍。在数据处理方面,帮助飞桨集成 DALI;大规模训练,支持各类数据格式,ASP、CUDA 等算子函数 API;优化推理方面,开发了 Paddle-TRT,Deep Learning Examples;在规模部署方面,集成了 NCCL,开发了 Triton PaddlePaddle Backend。

刚才这些适配仅仅是让飞桨的开发者拥有高性能的推理训练成为可能,但是这些离行业开发者还很远,门槛还很高,难度还很大。为此,NVIDIA 将刚刚这些集成和优化的工作整合到三大产品线中:

NVIDIA NGC PaddlePaddle Container——NGC 飞桨容器,致力为开发者提供了一个最佳的飞桨开发环境,包含最新的 NVIDIA 工具包版本(CUDA, DALI 等)。

NVIDIA Deep Learning Examples——飞桨深度学习模型示例,让开发者能够快速使用一系列拥有极致性能的经典模型 ,例如 ResNet 50、BERT 等。

NVIDIA DLI (Deep Learning Institute)——飞桨共建课程。为了能更好地提高推训性能并简化代码,NVIDIA 深度学习培训中心(DLI)也准备了系列免费课程,以及由 NVIDIA 与飞桨联名的 DLI 课程证书,赋能开发者并给于权威认可。

在这三大举措中,NGC 飞桨容器最为引人注目。

飞桨和 NVIDIA 团队从与开发者用户的持续交流中,收集到了一些使用上的痛点需求。比如,在提供 NGC 飞桨容器前,飞桨用户如果希望使用 NVIDIA 最新软件栈进行开发、训练、部署,需要做大量的手动配置工作,这对不少用户而言是一个巨大的工程挑战。

针对这些需求,NVIDIA 与百度飞桨联合开发了 NGC 飞桨容器,将最新的飞桨与最新的 NVIDIA 的软件栈进行了无缝的集成与性能优化,最大程度地释放飞桨框架在 NVIDIA 最新硬件上的计算能力。这样,用户不仅可以快速开启 AI 应用,专注于创新和应用本身,还能够在 AI 训练和推理任务上获得飞桨 + NVIDIA 带来的飞速体验。

NGC 飞桨容器具有以下优点:

以月为单位升级更新,每月底发布全新版本,无需注册即可下载,支持多 GPU 和多节点系统。

适配最新版本的 NVIDIA 软件栈(例如最新版本 CUDA),更多功能,更高性能。

安全可靠。扫描漏洞和加密,适合在工作站、服务器、云上运行并经过测试。满足 NVIDIA NGC 开发及验证规范,质量管理。

专为企业和高性能计算设计,支持 Docker。

适配各种硬件环境:裸机、虚拟机、K8S、X86、ARM、Power、云、本地、边缘等。

应用广泛。适合各种工作内容、工作场景、各行业的应用。

性能优化。我们将其进行优化,并且具有很好的可扩展性。

为了让飞桨开发者用上基于 NVIDIA 最新的高性能硬件和软件栈,我们借用 NVIDIA NGC 完善的开发体系、质量管理、测试流程、文档规范、安全扫描等,开发了基于 NVIDIA GPU 平台最好的飞桨开发环境。

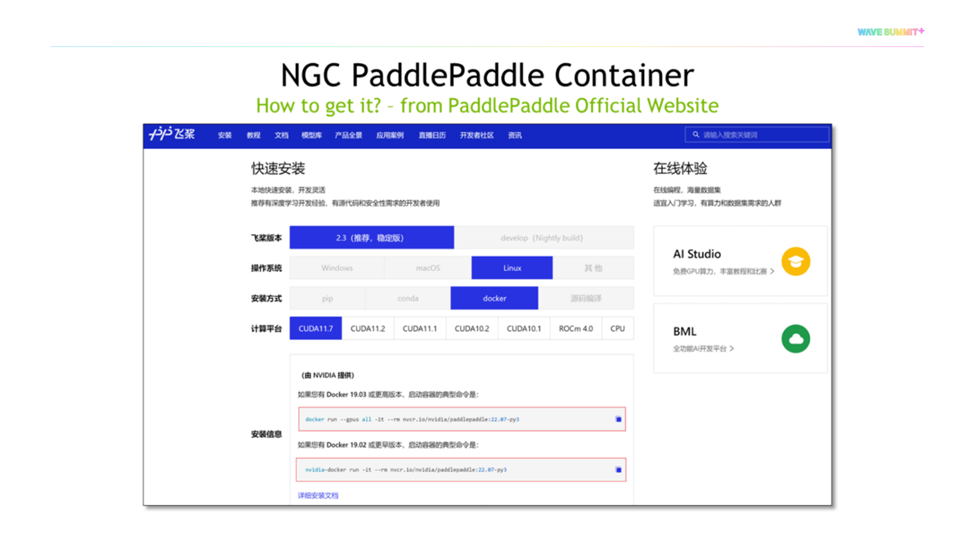

NGC 飞桨容器现已上线飞桨官网,开发者可以通过飞桨官网快速获取(如下图)。

下面,我们介绍一下 NVIDIA Deep Learning Examples,这是 NVIDIA 优化的工业级模型库,目标是让基于 NVIDIA GPU 的开发者复现极致精度和高性能的模型。NVIDIA Deep Learning Examples 中包括针对不同行业的模型,包括机器人、数字孪生、金融等等。

今年我们发布了 NVIDIA Deep Learning Examples PaddlePaddle ResNet50,只需要在 GitHub 中打开 NVIDIA Deep Learning Examples Repo,找到主页中的 PaddlePaddle Classification ResNet50 文件就可以得到它,里面有非常丰富的文档和信息。NVIDIA 基于各类网卡、A10、A30,基于各类拓扑结构,单机单卡、单机多卡等,都做了大量测试,并分享了详细的 Benchmark 供开发者参考(如下图)。

在本届 WAVE SUMMIT+ 开始前,NVIDIA 更与百度飞桨联合主办了“2022 飞桨 × NVIDIA AI 技术开放日”。作为 WAVE SUMMIT+ 的 “前哨站” ,本次活动邀请双方公司的 AI 技术专家与超过 2000 名开发者共同开展深度技术交流,内容囊括 NGC 飞桨容器特点、应用场景、模型优化,以及部署实践案例。

欲了解更多 NGC 飞桨容器,可查看以下延展介绍,或关注微信公众号【NVIDIA 英伟达企业解决方案】。

详细产品介绍视频

【飞桨开发者说|NGC 飞桨容器全新上线 NVIDIA 产品专家全面解读】

https://www.bilibili.com/video/BV16B4y1V7ue?share_source=copy_web&vd_source=266ac44430b3656de0c2f4e58b4daf82

详细安装介绍

【NGC 飞桨容器安装指南】

https://www.paddlepaddle.org.cn/documentation/docs/zh/install/install_NGC_PaddlePaddle_ch.html

分享到微信

分享到微信

分享到微博

分享到微博