使用微软Azure Stack HCI 和 NVIDIA BlueField DPU 加速企业应用程序

2022-11-29 12:22

随着企业不断将工作负载转移到云端,一些应用程序需要留在本地,从而最大限度地提高延时性能,并满足安全性、数据独立性和合规性策略。Microsoft Azure Stack HCI 是作为 Azure 服务提供的超融合基础架构(HCI)堆栈。Azure Stack HCI 提供内置的安全性和可管理性,非常适合在核心和边缘数据中心运行生产工作负载和云原生应用程序。

NVIDIA BlueField DPU(数据处理器)是一个加速的数据中心基础设施平台,可释放应用程序性能和系统效率。NVIDIA BlueField DPU 帮助有上云意识的企业克服现代 IT 环境中的性能和可扩展性瓶颈。这是通过卸载、加速和隔离软件定义的基础设施工作负载来实现的。

微软展示了在 NVIDIA BlueField-2 DPU 上加速的 Azure Stack HCI 平台原型,标志着性能和生产力的重大飞跃,可提升 12 倍的 CPU 资源效率和 60% 的吞吐量。DPU 加速的 HCI 平台只需更少的服务器、更低的能耗和更少的空间即可运行指定的工作负载,从而显著节省了总体拥有成本(TCO)。

性能与效率提升

Azure Stack HCI 是一个软件定义的平台,它运行 Azure 网络堆栈,用于将虚拟机(VM)和容器连接在一起。软件定义的网络提供了丰富的功能和极大的灵活性,使企业能够轻松地从单个本地数据中心扩展到混合云和多云环境。

尽管软件定义的网络有许多好处,但它们仅在 CPU 上运行就会受到资源限制。它们以窃取原本用于运行业务应用程序的昂贵 CPU 核心而闻名,从而降低性能和可扩展性。此外,软件定义网络(SDN)技术与硬件加速网络(即 SR-IOV)长期存在冲突。这迫使云架构师必将一个优先于另一个,通常以应用程序性能较差或 TCO 较高为代价。

NVIDIA BlueField DPU 旨在提供两全其美:SDN 的功能性和灵活性以及硬件加速网络(SR-IOV)的性能和效率。NVIDIA BlueField DPU 将整个 SDN 工作负载从主机 CPU 上卸下,为业务线应用程序释放 CPU 核心,从而节省了大量 TCO 。

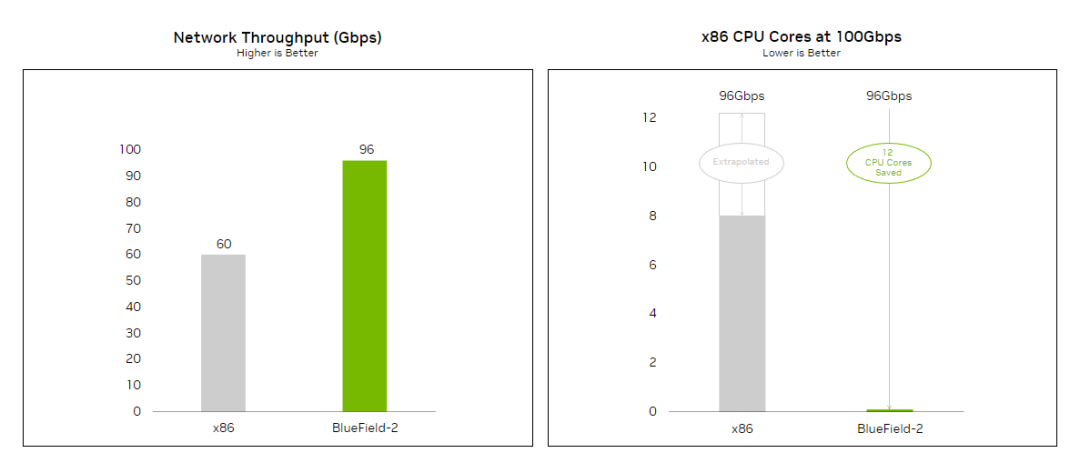

在 NVIDIA BlueField DPU Arm 处理器中运行的SDN 管道被映射到 NVIDIA BlueField DPU 加速可编程管道,以提高吞吐量和数据包处理性能并减少延时。通过在 NVIDIA BlueField-2 DPU 上卸载和加速 Azure Stack HCI SDN 功能,Microsoft 团队能够实现巨大的性能和效率提升(图 1)。

图 1. 在 NVIDIA BlueField-2 DPU 上加速 Azure Stack HCI 可提高网络吞吐量(左)和节省 CPU 核心(右)

测试结果表明,NVIDIA BlueField-2 DPU 以 96 Gb/s 的速度提供线速速率、软件定义的网络,CPU 使用率几乎为零,而在使用 8 个 CPU 核心时仅为 60 Gb/s。这 8 个核心现在可以腾出来运行业务工作负载,网络速度提高 60%。

因为 x86 CPU 无法达到 100Gb/s 的测试,为了保证相同的对比条件,我们根据条件推测出支持 96 Gb/s 所需的 CPU 核心数量。图 1 显示,支持 96 Gb/s 需要 12 个 CPU 核心,这意味着 NVIDIA BlueField-2 DPU 节省了 12 个 CPU 核心以支持相同的吞吐量。

这种节省使企业能够设计、部署和操作更少的服务器,以提供相同的业务成果,或者基于相同数量的服务器实现更好的成果。

从功能角度来看,Microsoft Azure Stack HCI 平台支持广泛的 SDN 策略:VXLAN 网络封装和解封装(encap / decap)、访问控制列表(ACL)、服务质量(QoS)、IP-in-IP 封装、网络地址转换(NAT)、IPsec 加密/解密等。VM 的加速网络(SR-IOV)的传统配置将需要绕过这组丰富的策略,以实现更高的性能。

Azure Stack HCI 解决方案原型现已在 NVIDIA BlueField DPU 上卸载并加速,可在不牺牲性能和效率的情况下同时提供高级 SDN 策略。

总结

在将工作负载转移到云的同时,企业继续优先考虑本地和边缘数据中心,以满足严格的性能和安全要求。包括机器学习和人工智能在内的下一代应用越来越依赖于加速网络来实现其全部潜力。NVIDIA BlueField DPU 原型上的 Microsoft Azure Stack HCI 为各种规模的企业提供了混合云和加速网络的承诺。

分享到微信

分享到微信

分享到微博

分享到微博