通过更智能的网络加速边缘计算

2021-06-18 18:15

同传统将数据发送至数据中心的方法相比,在产生数据的位置就立即分析和使用数据的需求越来越多,导致人们对边缘计算的需求迅速增长。新的应用已经无法等待数据发送到中央服务器进行分析,再返回结果的过程了,它们需要对数据进行就地实时分析。

为满足这一需求,NVIDIA 宣布扩展 NVIDIA EGX 平台和生态系统,包括服务器供应商认证、混合云合作伙伴、以及能够实现 GPU 服务器云原生部署的全新 GPU Operator 软件。

随着算力向边缘移动,NVIDIA 发现更智能的边缘计算需要更智能的网络,因此 EGX 生态系统包含了 NVIDIA 网络解决方案。

物联网带动边缘计算需求

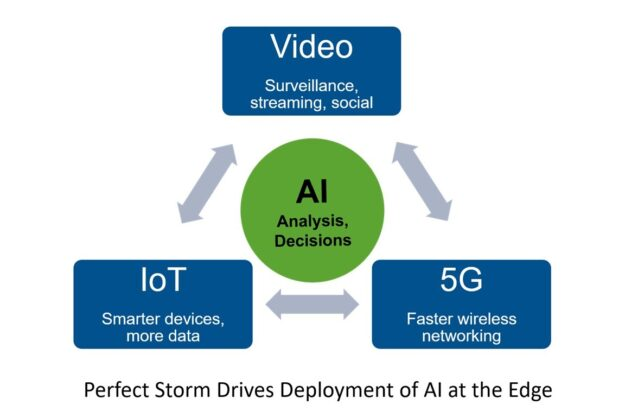

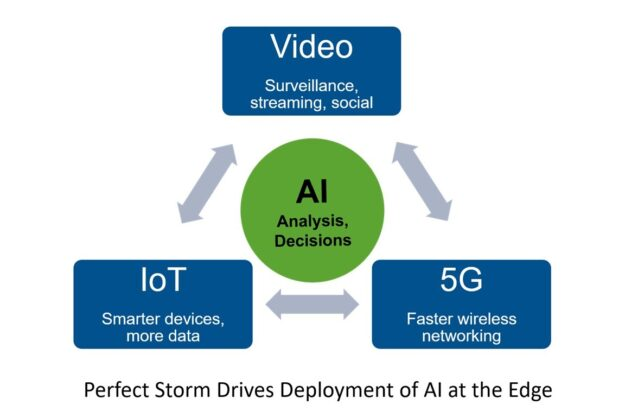

物联网(IoT)、5G 无线网络和 AI 的发展都在推动计算向边缘的移动。随着物联网的出现,更多更加智能的设备正在生成和消耗更多的数据,而这些数据位于远离传统数据中心的地点。

自动驾驶汽车、数字摄像机、信息亭、医疗设备、建筑传感器、智能收银机、位置标签,当然还有手机等,很快将会通过数十亿个终端生成数据,这些数据必须经过采集、过滤和分析,所提炼出的结果往往会被转移到另一个数据中心或位于其他地点的终端。

在不进行任何边缘处理的情况下将所有数据传输回数据中心会大幅增加延迟。这些数据量对于广域网传输而言往往都过大了,甚至数据中心的空间往往都不足以用来存储所有来自边缘的、未经过滤和压缩的数据。

5G 给边缘带来了更高的带宽和更低的延迟,这使得物联网设备的数据采集和新应用变得更快。以前无法采集或共享的数据现在可以通过无线网络获得。更快的无线连接速度使新的应用可以在边缘实时地使用并响应数据,不必等待需要分析的数据被集中存储后进行分析。

AI 可以从所有新数据中提取更多有用的信息来推动快速决策。由于物联网数据十分庞杂,人工无法对它们进行分析,因此需要使用 AI 技术对它们进行过滤,从噪声中滤出信号。并将 AI 的决策提供给在边缘和中央数据中心的应用程序。

物联网和5G无线技术推动AI计算边缘部署的增加

NVIDIA EGX 可提供边缘 AI

图像识别、视频处理和机器人技术等许多边缘 AI 应用都需要大规模的并行处理能力,而 NVIDIA GPU 在这一领域一马当先。

为了满足边缘对先进 AI 处理能力的需求,NVIDIA 发布了 EGX 平台。该平台能够支持各种具有超高可扩展性的 GPU 服务器,无论是单个 NVIDIA Jetson Nano 系统,还是一整机架的 NVIDIA T4,亦或是 V100 Tensor Core 服务器,都囊括其中。Jetson Nano 可以提供每秒 0.5 万亿次运算性能,而一整机架的 T4 服务器的性能可达到每秒万万亿次运算(10,000 TOPS)。

NVIDIA EGX 还包括容器型工具、驱动程序和 NVIDIA CUDA-X 库,能够为边缘 AI 应用提供支持。EGX 获得了主要服务器供应商的支持,并且通过与红帽 OpenShift 平台的整合来实现基于 Kubernetes 的企业级容器编排。这点十分关键,因为对于许多边缘计算的位置,例如零售店、医院、自动驾驶汽车、家庭、工厂和手机端等,为其提供支持的都是企业、地方政府和电信公司,而非超大规模数据中心。

NVIDIA 最近发布了 EGX 的新功能和客户部署情况,以及其对混合云解决方案的强大支持。NGC-Ready 服务器认证计划扩展后已加入边缘安全测试和远程管理测试,并且,全新 NVIDIA GPU Operator 简化了各分散边缘设备上的 AI 管理和运行。

NVIDIA EGX 平台包括 GPU、CUDA-X 接口、容器管理

以及经过认证的硬件合作伙伴

更智能的边缘需要更智能的网络

为了使 EGX 以及边缘 AI 变得尽可能智能和高效,还需要网络的强大支持。因为随着边缘 GPU 处理能力和容器数量的增加,网络流量也会呈指数级增长。

在 AI 出现之前,可分析的边缘数据流量(不包括流向手机的图形、视频和音乐)中可能有 95% 是流入的流量。例如,数据可能从照相机流向数字录像机、从汽车流向服务器或从零售店流向中央数据中心。由于每个人只能专注于观察一个视频流,因此任何分析或洞察往往都取决于人。这些数据可能会被储存起来供以后使用,缺乏作出实时决策的能力。

现在,随着像 EGX 这样的 AI 解决方案在边缘的部署,应用必须与物联网设备通信、响应数据中心的服务器,并相互通信。AI 应用将与标准 CPU 交换数据和结果,来自边缘的数据将与来自企业数据中心或公有云的数据合成,并且结果会被推送回信息亭、汽车、家电、MRI 扫描仪和手机。

如此,容器、物联网设备、GPU 服务器、云和传统的集中式服务器之间产生了大量且多路的数据流量。软件定义网络(SDN)和网络虚拟化所发挥的作用变得更大。但扩展后的网络带来了新的安全问题——黑客和恶意软件的潜在攻击面远超以往,而且无法被控制在防火墙内。

随着网络变得更加复杂,网络的许多方面必须变得更加智能,比如:

必须在容器、虚拟机和裸金属服务器之间高效传输数据包。

网络功能虚拟化(NFV)和 SDN 需要加速数据包交换(在用户空间或内核空间中)。

为了使用 RDMA,网卡需具备硬件卸载功能,交换机需具备智能流量管理功能。

为了确保安全,存储和传输中的数据都必须进行加密。任何被加密的数据必须在某个时间解密。

随着物联网数据的增长,以及从硬盘向闪存的转变,必须对数据进行压缩和去重以控制存储成本。

这些增加的网络复杂性和安全问题给边缘服务器以及与它们连接的企业和云服务器带来的负担日渐增多。

随着 AI 更多的应用以及网络速度的加快,如果没有合适的智能网络,处理网络虚拟化、SDN 规则和安全过滤则会占用宝贵的 CPU 周期。网络连接速度的加快使得各网络智能功能必须在硬件中加速,而不是在软件中运行。

智能网卡节省边缘计算周期

更智能的边缘计算需要更智能的网络。如果该网络由 CPU 或 GPU 处理,那么宝贵的计算资源就会被用于移动数据而不是分析和转换数据。在应用中,必须对覆盖网络的数据包头进行处理、确定哪个数据包进入哪个容器并确保遵守 SDN 规则。

由于需要根据来源、目的地、数据包报头、甚至是数据包的内部内容来过滤数据包,因此软件定义防火墙和路由器会增加 CPU 的负担。之后,还需要根据网络规则来转发、映射、重新引导或丢弃数据包。

幸运的是,有一类价格合适的智能网卡(比如 NVIDIA ConnectX 系列)可以卸载所有在 CPU 上的这些工作。这些网卡具有硬件加速功能,因此可以处理 Overlay 覆盖网络、RDMA、容器、虚拟交换、存储网络和视频流,还能加速网卡端的网络拥塞管理和 QoS。

ConnectX-6 Dx 等最新网卡可在硬件中高速执行在线加密和解密,支持 IPsec 和 TLS 协议。网卡可以安全加速这些重要且反复的网络任务,因此部署在边缘的 CPU 和 GPU 能够快速、高效地互相协作,处理物联网的业务,同时将它们的计算资源集中在它们最擅长的工作上——运行应用和并行处理复杂数据。

BlueField DPU

增加针对恶意软件和过载的额外保护

为了提高边缘计算效率,可以选择 DPU(数据处理器)这一更先进的网络选项,例如 NVIDIA BlueField DPU。DPU 同时具备智能网卡的所有高速网络和卸载功能,其可编程核能够处理网络、存储或安全相关的附加功能。

它可以卸载 SDN 数据平面和控制平面功能。

它可以实现CPU或GPU的闪存虚拟化。

它可以在一个单独域中部署安全保障以超高水平抵御恶意软件。

在安全方面,BlueField DPU 可以提供安全域隔离。在没有隔离的情况下,任何安全软件都是与操作系统、容器管理和应用在同一域中运行。如果攻击者破坏了其中的任何一项,那么安全软件就有可能被绕过、删除或破坏。

有了 BlueField,安全软件据可以继续在 DPU 上运行并检测、隔离和报告服务器上的恶意软件或漏洞。由于是在一个受硬件信任及保护的单独域中运行,因此安全功能可以向入侵检测和预防机制发出警报,同时防止恶意软件在被感染的服务器上传播。

最新 BlueField-2 DPU 还增加了正则表达式(RegEx)匹配,可以快速检测网络流量或服务器内存中出现的特别模式,因此可识别潜在的威胁。它还增加了硬件卸载功能,通过 SHA-2 散列算法去重,以及压缩/解压缩功能实来提高数据效率。

更智能的边缘网络

随着 NVIDIA EGX 平台等边缘 AI 解决方案的增加,边缘正在变得越来越智能。但与此同时,物联网和 5G 无线网络的发展需要消耗更多的算力,网络和安全性变得更加复杂,这让服务器速度变慢。

这些问题都可以通过部署智能网卡和 DPU 来解决,例如 ConnectX 和 BlueField 产品系列。这些网络解决方案能够卸载网络和安全任务,例如 SDN、网络虚拟化和软件定义防火墙功能等,从而使边缘 AI 可以更加有效、安全地运行。

分享到微信

分享到微信

分享到微博

分享到微博