GTC21 | 全新NVIDIA工作流程,让任何用户轻松选择、适配和部署

2021-04-17 14:36

学会运用如NVIDIA TAO和Fleet Command这类预训练模型与工具,AI驱动型企业的发展之路不再曲折漫长。AI 是我们这个时代最强大的新技术,但迄今为止,许多企业一直难以驾驭这种力量。

许多公司缺乏专业技能、无法访问大型数据集或缺乏深度学习所需的加速计算。还有一些公司则认识到 AI 的优势,并想要将其快速推广到更多产品和服务中。

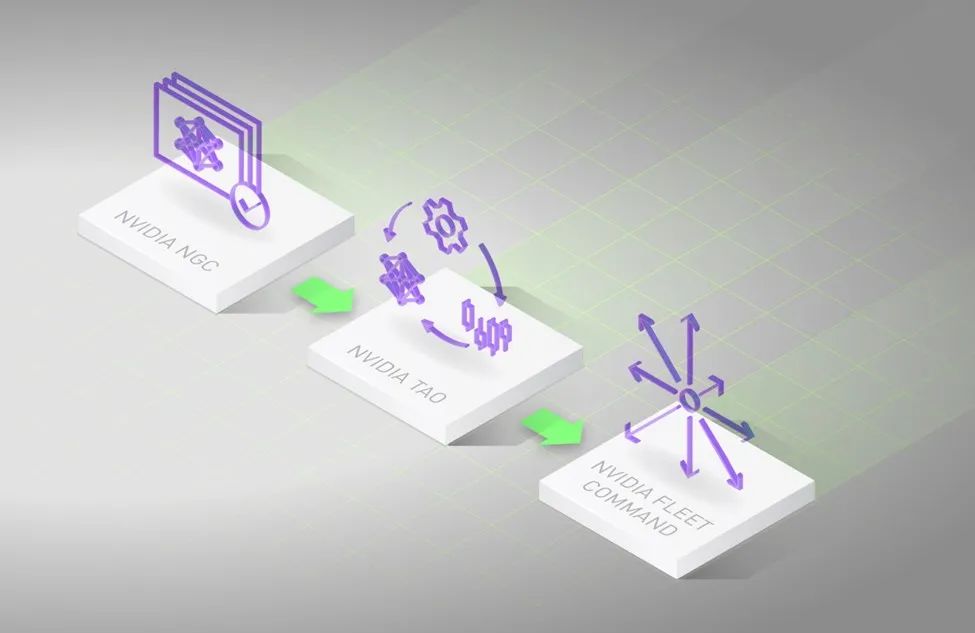

应对这两者的挑战,企业 AI 有了新的路径。新的路径利用成熟的技术,并借助 NVIDIA TAO 和 NVIDIA Fleet Command 简化 AI 工作流,达到缩短时间、降低成本的效果。

即抓即用的 AI 模型

这一过程的起点是预训练模型开始。2021 年,你已经不必从头开始设计和训练神经网络,而是可以在我们的 NGC 目录中众多的模型中进行选择。

我们策划了众多的模型以交付业务技能进而可以推进你的业务,这些模型包括计算机视觉、对话式 AI 、乃至自然语言理解等等多个领域的AI任务。

模型都有它的 AI 简历页面

因此,用户可以了解他们获得的模型,且目录中的许多模型都提供凭证 —— 就像潜在新员工的简历一样。

模型凭证显示了模型训练的领域、训练模型的数据集、模型的部署频次及其预计的运行性能。这些信息确保了透明性和可信性,使你可以为应用案例选择正确的模型。

利用大量投资

NVIDIA 五年来投入了数亿个 GPU 计算小时来完善和调试这些模型——我们替你完成了这项工作,所以你无需费力。

这里有三个R&D的案例可以助你一臂之力:

在计算机视觉方面,我们投入了 3,700人年在 4500 万帧中标记了 5 亿个物体。我们使用录音在 GPU 上对语音模型进行了超过 100 万小时的训练。我们用包含 61 亿个单词的生物医学论文数据库来训练了我们的自然语言处理模型。

迁移学习,你的 AI 私人定制

选择模型后,你可以使用 NVIDIA TAO 对其进行精调,以满足你的特定需求。NVIDIA TAO 是我们加速企业 AI 工作流程的又一个里程碑。

TAO 支持迁移学习,这个过程从现有的神经网络中获取特征,并使用 NVIDIA 的Transfer Learning Toolkit(TAO 的组成部分)将其移植到新的网络中。它利用用户手头的小型数据集,为模型提供自定义适配,而无需从头开始构建和训练神经网络所需的成本、时间和大量数据集。

有时,公司有机会通过合作伙伴在数据中心外维护的更大、更多样化的数据集中训练模型,以进一步增强模型。

借助 TAO,合作伙伴可以安全的相互协作

联邦学习(Federating Learning)是 TAO 的另一部分内容,它允许不同站点安全地协作,以优化模型从而达到最高的精度。借助此技术,用户可以共享模型部分模块(例如部分权重)。数据集得以保留在每家公司的数据中心内,因此数据隐私得到了保护。

在最近的一个示例中,20 个研究点合作提高了所谓的“EXAM”模型的准确性,该模型可以预测患者是否患有 COVID-19。应用联合学习后,该模型还可以预测感染的严重程度以及患者是否需要补氧。患者数据安全地隐藏在每个合作伙伴手中。

将企业 AI 应用到生产中

模型经过微调后,需要针对部署进行优化。这是一个模型修剪过程,使模型更加精简且鲁棒,因此,无论是在服务器中的 GPU阵列上,还是在工厂车间中由 Jetson 控制的机器人上,模型在目标平台上都能高效运行。

NVIDIA TensorRT 是 TAO 的另一部分,它根据模型运行的目标系统,对模型进行数学的调整从而使其达到最小规模与最高精度的最优化平衡。这是一个关键步骤,对于语音识别或欺诈检测等不允许系统延迟的实时服务而言尤为重要。

此外,利用Triton 推理服务器(Triton Inference Server),不论模型架构如何、模型是什么框架、抑或运行于哪个目标CPU或GPU,用户都可以选择最佳配置来进行部署。

一旦模型得到优化并准备部署,用户就可以轻松地将其集成到适合其使用案例或行业的任何应用框架中。例如,对话式 AI 可以采用 Jarvis 、医疗应用可以采用 Clara 、Metropolis 用于视频分析,或者 ISAAC 用于机器人领域等,以上只是几个 NVIDIA 产品示例。

借助所选应用程序框架,用户可以启动 NVIDIA Fleet Command,以在各种 GPU 支持的设备中部署和管理 AI 应用程序。这是整个过程的最后一个关键步骤。

数分钟内实现从零到 AI

Fleet Command 连接部署在网络边缘至云端 NVIDIA 认证服务器(NVIDIA Certified Servers)的服务器。有了它,用户可以从浏览器中安全地配对、编排和管理数百万台服务器,将AI应用部署到任何远程位置,并根据需要更新软件。

管理员可以集中监控运行状况,并一键远程更新系统,以简化大规模 AI 运维。

Fleet Command使用端到端安全协议来确保应用程序数据和知识产权的安全。

数据在边缘和云之间发送,经过完全加密,可确保其受到保护。在部署应用程序之前,会先对应用程序进行恶意软件和漏洞扫描。

工作上的 AI 工作流程

Fleet Command和TAO的要素已经在仓库、零售、医院和工厂车间使用。用户包括埃森哲、宝马和西门子数字工业等公司。

下方来自 GTC 主题演讲的视频展示了 NGC 模型、TAO 和 Fleet Command 的组合,是如何将多个 AI 模型快速定制和部署成为应用程序的。

即刻起,可注册 Fleet Command。

TAO 的核心部分,如迁移学习工具包(Transfer Learning Toolkit)和联邦学习(federated learning)已经公开可用。立即申请Early Access,解锁完全集成到 TAO 中的所有技术。

分享到微信

分享到微信

分享到微博

分享到微博