NVIDIA推理性能再创新高,AI部署跨越重要里程碑

2020-10-24 11:42

随着AI在全球的不断普及,NVIDIA与合作伙伴打破了所有MLPerf数据中心和边缘基准测试的记录。

在应用中使用AI进行推理工作逐渐成为主流,而且其运行速度再创新高。

NVIDIA GPU在最新一轮数据中心和边缘计算系统的全部AI推理测试中胜出,该测试是业内唯一基于联盟、同行评审的基准测试。

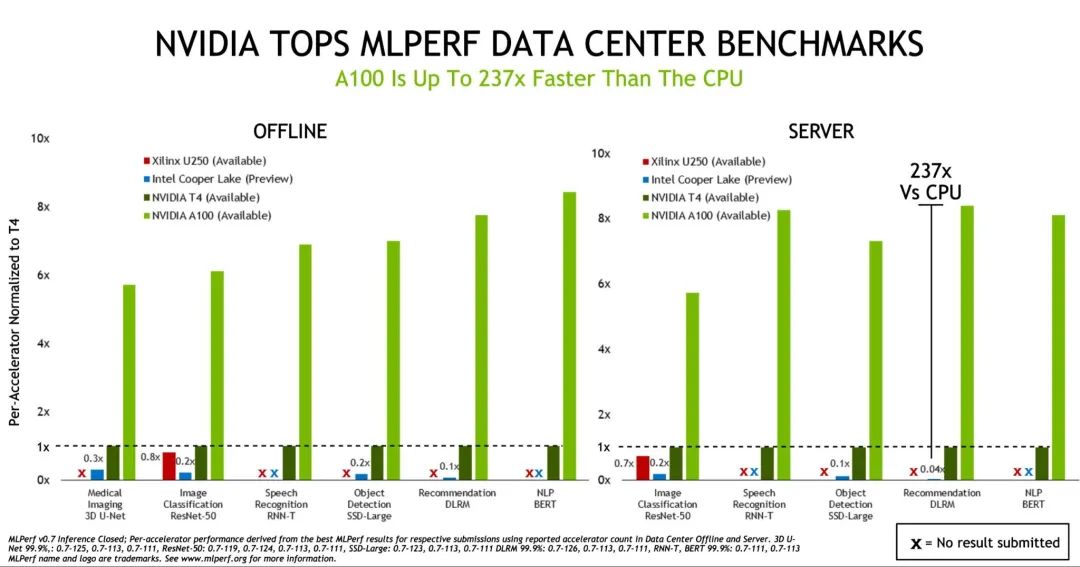

NVIDIA A100和T4 GPU问鼎所有数据中心推理测试

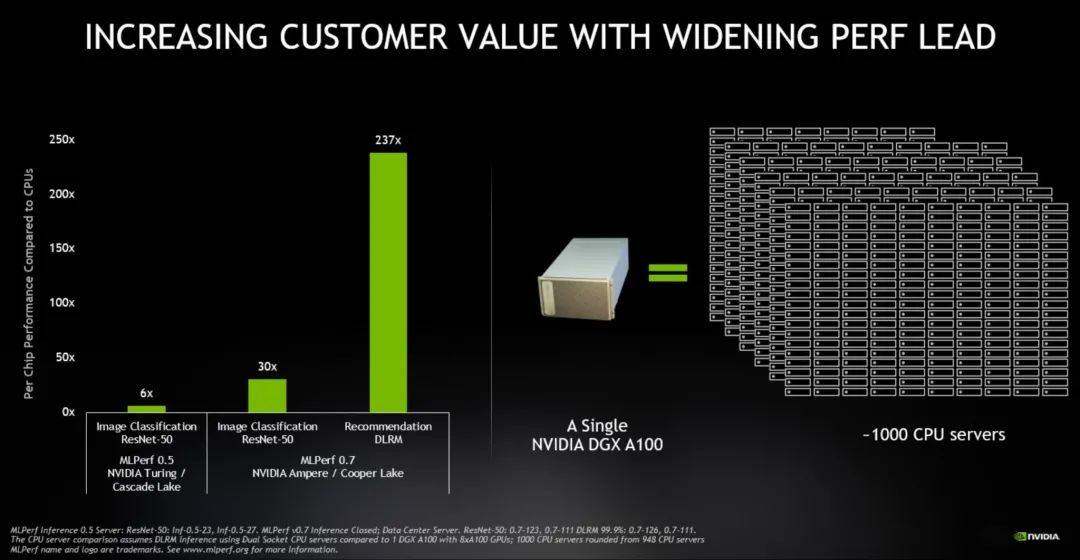

NVIDIA凭借NVIDIA A100 Tensor Core GPU继续扩大了在MLPerf AI推理测试中的性能优势。MLPerf行业基准测试联盟于2018年5月成立,去年,该联盟首次举办AI推理测试。

在MLPerf Inference 0.7基准测试中,今年5月发布的A100的数据中心推理性能比CPU高237倍。在同一测试中,NVIDIA T4小型高能效GPU的性能比CPU高出28倍。

由此可见,一套搭载八个A100 GPU的NVIDIA DGX A100系统,可以提供相当于部分AI应用上近1000台双路CPU服务器的性能。

领先的性能可提高成本效益,将AI研究转化为生产力

本次基准测试的参与者也有所增加。有23家机构提交了测试结果(上一次为12家),其中85%的参评测试结果由NVIDIA的合作伙伴基于NVIDIA AI平台提交。

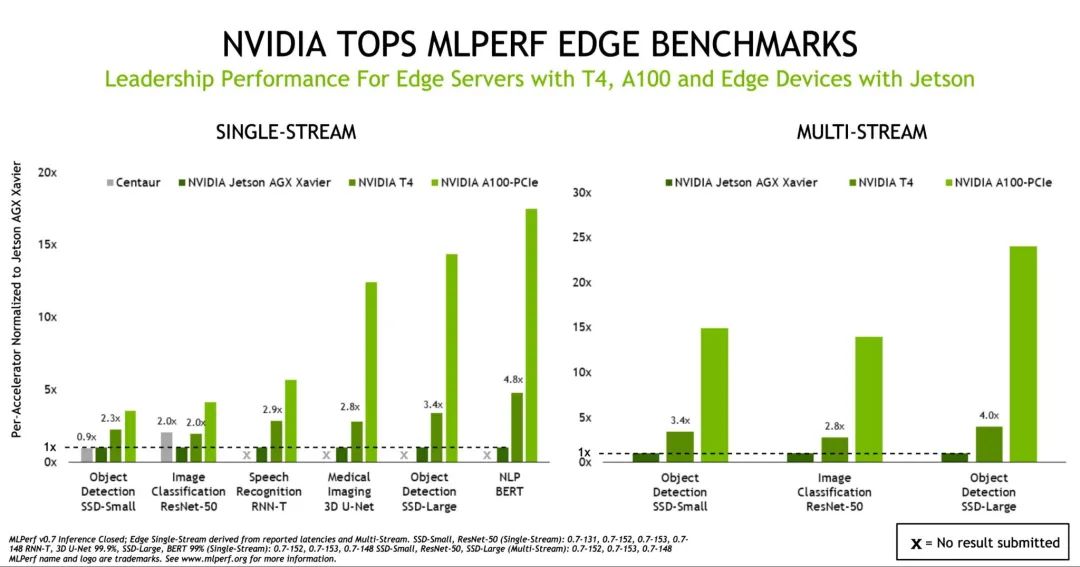

A100 GPU、Jetson AGX Xavier领导边缘设备性能

虽然A100将AI推理性能提升到了新的高度,但基准测试表明,T4仍然是主流企业、边缘服务器和高成本效益云实例的可靠推理平台。此外,NVIDIA Jetson AGX Xavier通过支持所有新用例,进一步巩固了其在功耗受限的基于Soc的边缘设备中的领导地位。

Jetson AGX Xavier、A100和T4 GPU共同领导边缘设备性能

本次测试结果离不开NVIDIA蓬勃发展的AI生态系统。该生态系统提交了基于NVIDIA解决方案的1,029个测试结果,占数据中心和边缘类别中参评结果总数的85%。所提交的数据印证了合作伙伴系统的稳定性能,合作伙伴包括Altos、源讯、思科、戴尔易安信、Dividiti、富士通、技嘉、浪潮、联想、宁畅和QCT。

不断扩展的用例将先进的AI技术带入日常生活

在业界和学界的广泛支持下,MLPerf基准测试不断扩展,涵盖更多行业用例。目前支持MLPerf的机构包括:Arm、百度、Facebook、谷歌、哈佛、英特尔、联想、微软、斯坦福大学、多伦多大学和NVIDIA。

最新的基准测试引入了四项新测试,突显了AI领域的广阔前景。该套件目前对自然语言处理、医疗影像、推荐系统、语音识别以及计算机视觉中的AI用例进行性能评分。

您只需要在搜索引擎上搜索一下,就可以了解自然语言处理对我们日常生活的影响。

微软搜索和人工智能副总裁Rangan Majumder表示:“基于近期在自然语言理解方面所实现的AI技术突破,越来越多像Bing这样的AI服务可以更自然地进行交互,并在不到一秒的时间内提供准确而实用的结果、答案和建议。”

他还表示:“MLPerf基准测试作为行业标杆,可提供广泛使用的AI网络的相关性能数据,帮助人们做出明智的AI平台购买决策。”

在疫情期间,利用AI挽救生命

AI在医疗影像领域的影响进一步扩大。初创公司Caption Health使用AI简化超声心动图检查工作,在COVID-19疫情初期帮助美国医院挽救患者生命。

因此,医疗AI领域的意见领袖将最新MLPerf基准测试中所使用的3D U-Net等模型,视为该领域发展的关键。

德国癌症研究中心(DKFZ)医疗影像计算主管Klaus Maier-Hein表示:“我们与NVIDIA展开密切的合作,将3D U-Net等创新技术引入医疗市场。”

他还表示:“计算机视觉和影像技术是AI研究的核心。该技术推动了科学研发,并代表了医疗健康领域的核心。作为行业标杆的MLPerf基准测试提供了相关的性能数据,帮助IT组织和开发者加速其特定项目和应用。”

在商业领域,推荐系统等AI用例(已被加入到最新MLPerf测试中)可产生巨大的影响。去年11月,阿里巴巴使用推荐系统在“双十一”这一年度最大购物日实现了380亿美元的在线销售额。

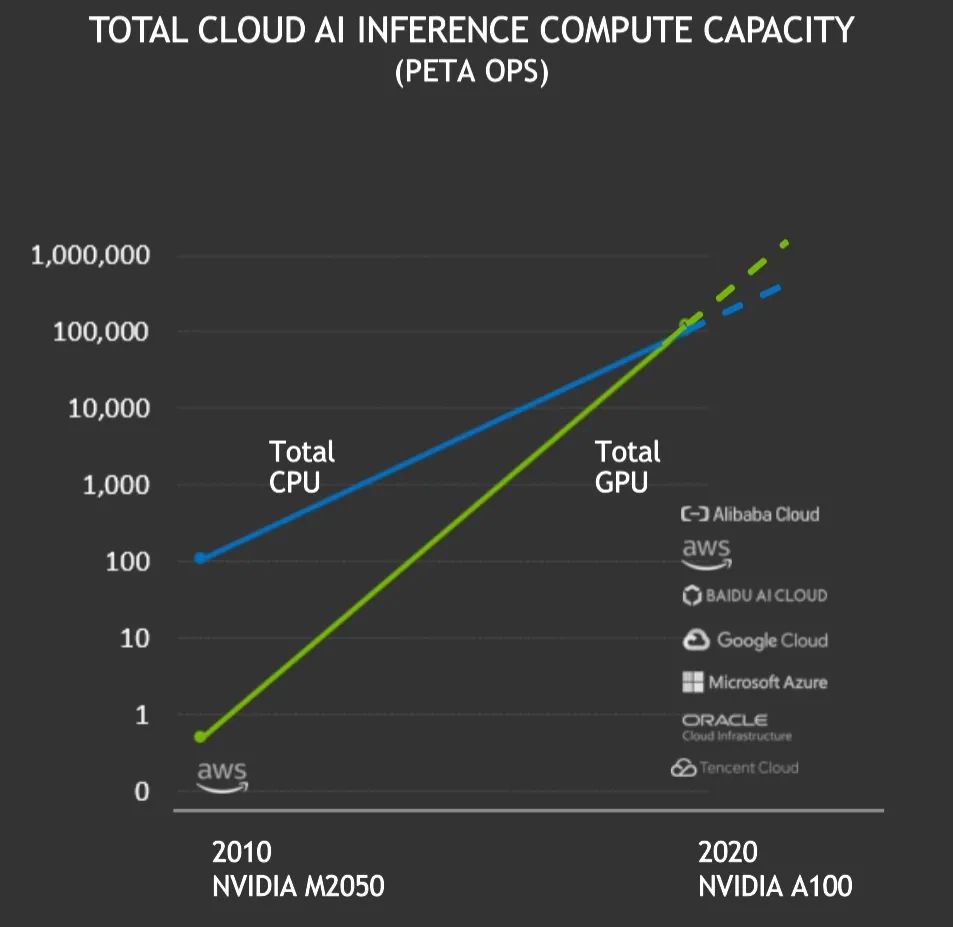

NVIDIA AI推理部署跨越重要里程碑

AI推理在今年跨越了一座重要的里程碑。

在过去的12个月中, NVIDIA GPU总计在公有云中提供了超过100 exaflops的AI推理性能,首次超越云端CPU的推理性能。基于 NVIDIA GPU的总体云端AI推理计算能力每两年增长约10倍。

如今,各大云服务中的GPU比CPU具备更强大的推理性能

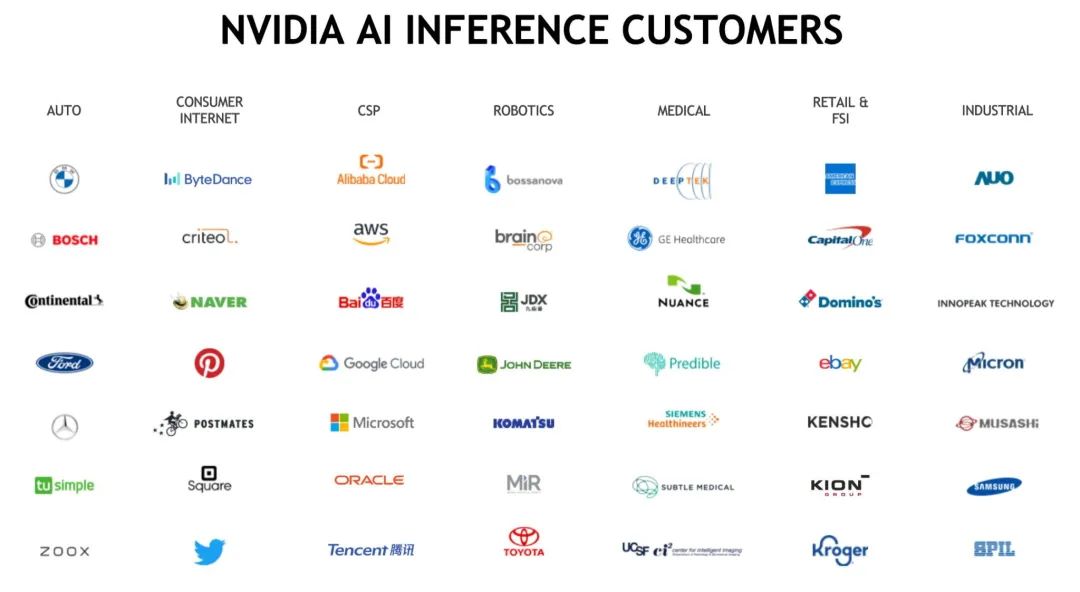

凭借NVIDIA GPU计算的高性能、实用性和可用性,越来越多的汽车、云、机器人、医疗健康、零售、金融服务和制造业等行业的公司均采用NVIDIA GPU进行AI推理,包括美国运通、宝马、Capital One、Dominos、福特、GE医疗、克罗格、微软、三星和丰田。

各大关键行业中的公司使用NVIDIA AI平台进行推理

为什么AI推理发展难度极高

AI用例正在快速扩展,但出于许多原因,AI推理的发展难度极高。

新的用例不断推动生成对抗网络等新型神经网络的涌现,且模型数量呈指数级增长。目前,用于AI的最佳语言模型包含数十亿个参数,并且该领域的研究尚处于起步阶段。

这些模型需要在云、企业数据中心和网络边缘中运行,因此运行它们的系统必须具备高度可编程性,以及多个维度上的卓越性能。

NVIDIA创始人兼首席执行官黄仁勋先生用一个词概述了其复杂的需求:PLASTER。现代化的AI推理需要出色的可编程性(P)、延迟(L)、精准性(A)、模型大小(S)、吞吐量(T)、能效(E)和学习速度(R)。

为了在各个维度上实现卓越性能,NVIDIA致力于不断优化自身端到端AI平台,使其能够处理对性能要求极高的推理工作。

AI对性能与实用性的要求

具备第三代Tensor Core核心和灵活的多实例GPU架构的A100等加速器只是开始。为了提供领先的测试结果,还需要完整的软件堆栈。

NVIDIA的AI软件包含各种用于运行AI推理的预训练模型。用户可以使用NVIDIA的迁移学习工具包,针对特定用例和数据集优化这些模型。

NVIDIA TensorRT优化经过训练的推理模型。目前,NVIDIA TensorRT已进行2000次优化,并被16000家企业机构下载130万次。

NVIDIA Triton 推理服务器提供一个经过调校的环境,来运行支持多个GPU和框架的AI模型。应用只需发送查询和限制(例如扩展到数千名用户所需的响应时间或吞吐量),其余的任务可以交给Triton处理。

这些重要的组成部分均在CUDA-X AI上运行。CUDA-X AI是一套基于NVIDIA加速计算平台的成熟软件库。

应用框架快速入门

最后,NVIDIA应用框架促进了企业AI在各个行业和用例中的普及。

目前,NVIDIA应用框架包括:用于推荐系统的NVIDIA Merlin、用于对话式AI的NVIDIA Jarvis、用于视频会议的NVIDIA Maxine、用于医疗的NVIDIA Clara等。

这些框架以及NVIDIA为最新MLPerf基准测试而提供的优化均可在NGC上获取。NGC是NVIDIA GPU加速软件中心,可在所有NVIDIA认证的OEM系统和云服务上运行。

这样,整个社会都能受益于NVIDIA的工作成果。

分享到微信

分享到微信

分享到微博

分享到微博