NVIDIA全新Ampere数据中心GPU全面投产

2020-05-16 08:52

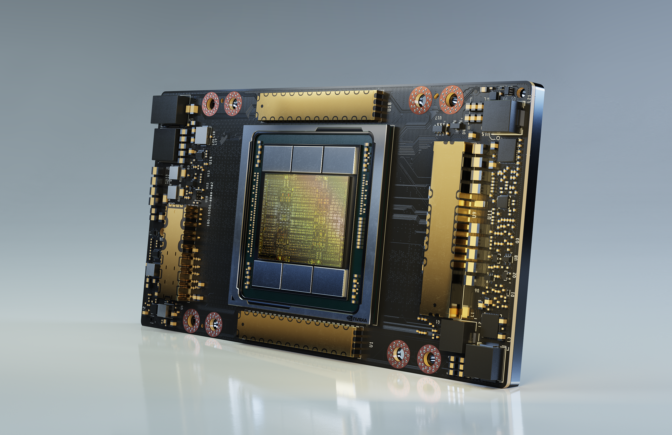

NVIDIA于今日宣布首款基于NVIDIA® Ampere架构的GPU —— NVIDIA A100已全面投产并已向全球客户交付。

A100采用了NVIDIA Ampere架构的突破性设计,该设计为NVIDIA第八代GPU提供了迄今为止最大的性能飞跃,集AI训练和推理于一身,并且其性能相比于前代产品提升了高达20倍。作为一款通用型工作负载加速器,A100还被设计用于数据分析、科学计算和云图形。

NVIDIA创始人兼首席执行官黄仁勋表示:“云计算和AI的强大趋势正在推动数据中心设计的结构性转变,过去的纯CPU服务器正在被高效的加速计算基础架构所取代。NVIDIA A100 GPU作为一个端到端的机器学习加速器,其实现了从数据分析到训练再到推理20倍的AI性能飞跃。这是有史以来首次,可以在一个平台上实现对横向扩展以及纵向扩展的负载的加速。NVIDIA A100将在提高吞吐量的同时,降低数据中心的成本。”

A100所采用的全新弹性计算技术能够为每项工作分配适量的计算能力。多实例GPU技术可将每个A100 GPU分割为多达七个独立实例来执行推理任务,而第三代NVIDIA NVLink®互联技术能够将多个A100 GPU合并成一个巨大的GPU来执行更大规模的训练任务。

众多全球领先的云服务供应商和系统构建商计划将A100 GPU集成到其产品中,其中包括:阿里云、AWS、Atos、百度智能云、思科、Dell Technologies、富士通、技嘉科技、Google Cloud、新华三、HPE、浪潮、联想、Microsoft Azure、甲骨文、Quanta/QCT、Supermicro和腾讯云。

在全球范围内被迅速采用

Microsoft是首批采用NVIDIA A100 GPU的用户之一,计划充分利用其性能和可扩展性。

Microsoft公司副总裁Mikhail Parakhin表示:“Microsoft大规模应用前代NVIDIA GPU训练了全球最大的语言模型——Turing Natural Language Generation。Azure将使用NVIDIA 新一代A100 GPU训练更大型的AI模型,以推动语言、语音、视觉和多模态技术领域的最新发展。”

DoorDash是一个按需提供的食品平台,在大流行期间作为餐馆的生命线,它指出了拥有灵活的人工智能基础设施的重要性。

DoorDash的机器学习工程师Gary Ren表示:“现代复杂AI训练和推理工作负载需要处理大量的数据,像NVIDIA A100 GPU这样最先进的技术,可以帮助缩短模型训练时间,加快机器学习开发进程。此外,采用基于云的GPU集群还能够为我们提供更高的灵活性,可以根据需要扩容或缩容,将有助于提高效率、简化操作并节约成本。”

其他早期采用者还包括多所国家实验室以及一些全球顶尖高等教育和研究机构,它们都在使用A100支持其新一代超级计算机。以下是部分早期采用者:

---- 印第安纳大学(Indiana University),在美国,其Big Red 200超级计算机基于HPE的Cray Shasta系统。该超级计算机将支持科学研究和医学研究以及AI、机器学习和数据分析领域的前沿研究。

---- 利希超算中心(Jülich Supercomputing Centre),在德国,其JUWELS增速系统由Atos建造,专为极端计算能力和AI任务而设计。

---- 卡尔斯鲁厄理工学院(Karlsruhe Institute of Technology),在德国,正在与联想一起建造其HoreKa超级计算机。该超级计算机将能够在材料科学、地球系统科学、能源和动力工程研究以及粒子和天体物理学领域开展更大规模的多尺度模拟。

---- 马克斯普朗克计算和数据中心(Max Planck Computing and Data Facility),在德国,其借助于联想为其建造的新一代超级计算机Raven,为马克斯普朗克研究所(Max Planck Institutes)的高性能计算应用的开发、优化、分析和可视化提供了先进的支持。

---- 美国能源部国家能源研究科学计算中心(U.S. Department of Energy’s National Energy Research Scientific Computing Center),位于美国劳伦斯伯克利国家实验室(Lawrence Berkeley National Laboratory),其正在基于HPE的Cray Shasta系统建造新一代超级计算机Perlmutter。该超级计算机将被用于支持超大规模科学研究、开发新能源、提高能效以及探索新材料。

A100的五大突破

NVIDIA A100 GPU的突破性技术设计来源于五大关键性创新:

---- NVIDIA Ampere架构 - A100的核心是NVIDIA Ampere GPU架构,该架构包含超过540亿个晶体管,这使其成为全球最大的7纳米处理器。

---- 具有TF32的第三代Tensor Core核心 - NVIDIA广泛采用的Tensor Core核心现在已变得更加灵活、快速且易于使用。其功能经过扩展后加入了专为AI开发的全新TF32,它能在无需更改任何代码的情况下,使FP32精度下的AI性能提高多达20倍。此外,Tensor Core核心现在支持FP64精度,相比于前代,其为HPC应用所提供的计算力比之前提高了多达2.5倍。

--- 多实例GPU - MIG,一种全新技术功能,可将单个A100 GPU分割为多达七个独立的GPU,为不同规模的工作提供不同的计算力,以此实现最佳利用率和投资回报率的最大化。

--- 第三代NVIDIA NVLink - 使GPU之间的高速联接增加至原来的两倍,实现服务器的高效性能扩展。

--- 结构化稀疏 - 这种全新效率技术利用AI数学固有的稀疏性,使性能提升了一倍。

凭借这些新功能,NVIDIA A100成为了AI训练和推理以及科学模拟、对话式AI、推荐系统、基因组学、高性能数据分析、地震建模和金融预测等各种高要求工作负载的理想选择。

新系统已搭载NVIDIA A100,很快将登陆云端

于今日同时发布的还有NVIDIA DGX™ A100 系统,其内置8个由NVIDIA NVLink互联的NVIDIA A100 GPU。NVIDIA和官方合作伙伴现已开始供应该系统。

阿里云、AWS、百度智能云、Google Cloud、Microsoft Azure 、甲骨文和腾讯云正在计划提供基于A100的服务。

此外,众多全球领先的系统制造商也将提供各种基于A100的服务器,包括Atos、思科、Dell Technologies、富士通、技嘉科技、新华三、HPE、浪潮、联想、Quanta/QCT和Supermicro。

为帮助合作伙伴加快服务器的开发,NVIDIA开发了HGX A100服务器构建模块,该模块采用了多GPU配置的集成基板形式。

HGX A100 4-GPU通过NVLink实现GPU之间的完整互联, 8-GPU配置的HGX A100通过NVIDIA NVSwitch™实现GPU之间的全带宽通信。采用全新MIG 技术的HGX A100能够被分割为56个小型GPU,每个GPU的速度都比NVIDIA T4更快;或者也可以将其用作一台拥有10petaflops AI性能的巨型8-GPU服务器。

A100软件优化

NVIDIA还发布了多个软件堆栈更新,使应用程序开发者能够充分发挥A100 GPU创新技术的性能。这些更新包括了50多个新版本CUDA-X™ 库,可用于加速图形、模拟和AI;CUDA 11;多模态对话式AI服务框架NVIDIA Jarvis;深度推荐应用框架 NVIDIA Merlin;以及NVIDIA HPC SDK,其中包括能够帮助HPC开发者调试和优化A100代码的编译器、库和工具。

A100采用了NVIDIA Ampere架构的突破性设计,该设计为NVIDIA第八代GPU提供了迄今为止最大的性能飞跃,集AI训练和推理于一身,并且其性能相比于前代产品提升了高达20倍。作为一款通用型工作负载加速器,A100还被设计用于数据分析、科学计算和云图形。

NVIDIA创始人兼首席执行官黄仁勋表示:“云计算和AI的强大趋势正在推动数据中心设计的结构性转变,过去的纯CPU服务器正在被高效的加速计算基础架构所取代。NVIDIA A100 GPU作为一个端到端的机器学习加速器,其实现了从数据分析到训练再到推理20倍的AI性能飞跃。这是有史以来首次,可以在一个平台上实现对横向扩展以及纵向扩展的负载的加速。NVIDIA A100将在提高吞吐量的同时,降低数据中心的成本。”

A100所采用的全新弹性计算技术能够为每项工作分配适量的计算能力。多实例GPU技术可将每个A100 GPU分割为多达七个独立实例来执行推理任务,而第三代NVIDIA NVLink®互联技术能够将多个A100 GPU合并成一个巨大的GPU来执行更大规模的训练任务。

众多全球领先的云服务供应商和系统构建商计划将A100 GPU集成到其产品中,其中包括:阿里云、AWS、Atos、百度智能云、思科、Dell Technologies、富士通、技嘉科技、Google Cloud、新华三、HPE、浪潮、联想、Microsoft Azure、甲骨文、Quanta/QCT、Supermicro和腾讯云。

在全球范围内被迅速采用

Microsoft是首批采用NVIDIA A100 GPU的用户之一,计划充分利用其性能和可扩展性。

Microsoft公司副总裁Mikhail Parakhin表示:“Microsoft大规模应用前代NVIDIA GPU训练了全球最大的语言模型——Turing Natural Language Generation。Azure将使用NVIDIA 新一代A100 GPU训练更大型的AI模型,以推动语言、语音、视觉和多模态技术领域的最新发展。”

DoorDash是一个按需提供的食品平台,在大流行期间作为餐馆的生命线,它指出了拥有灵活的人工智能基础设施的重要性。

DoorDash的机器学习工程师Gary Ren表示:“现代复杂AI训练和推理工作负载需要处理大量的数据,像NVIDIA A100 GPU这样最先进的技术,可以帮助缩短模型训练时间,加快机器学习开发进程。此外,采用基于云的GPU集群还能够为我们提供更高的灵活性,可以根据需要扩容或缩容,将有助于提高效率、简化操作并节约成本。”

其他早期采用者还包括多所国家实验室以及一些全球顶尖高等教育和研究机构,它们都在使用A100支持其新一代超级计算机。以下是部分早期采用者:

---- 印第安纳大学(Indiana University),在美国,其Big Red 200超级计算机基于HPE的Cray Shasta系统。该超级计算机将支持科学研究和医学研究以及AI、机器学习和数据分析领域的前沿研究。

---- 利希超算中心(Jülich Supercomputing Centre),在德国,其JUWELS增速系统由Atos建造,专为极端计算能力和AI任务而设计。

---- 卡尔斯鲁厄理工学院(Karlsruhe Institute of Technology),在德国,正在与联想一起建造其HoreKa超级计算机。该超级计算机将能够在材料科学、地球系统科学、能源和动力工程研究以及粒子和天体物理学领域开展更大规模的多尺度模拟。

---- 马克斯普朗克计算和数据中心(Max Planck Computing and Data Facility),在德国,其借助于联想为其建造的新一代超级计算机Raven,为马克斯普朗克研究所(Max Planck Institutes)的高性能计算应用的开发、优化、分析和可视化提供了先进的支持。

---- 美国能源部国家能源研究科学计算中心(U.S. Department of Energy’s National Energy Research Scientific Computing Center),位于美国劳伦斯伯克利国家实验室(Lawrence Berkeley National Laboratory),其正在基于HPE的Cray Shasta系统建造新一代超级计算机Perlmutter。该超级计算机将被用于支持超大规模科学研究、开发新能源、提高能效以及探索新材料。

A100的五大突破

NVIDIA A100 GPU的突破性技术设计来源于五大关键性创新:

---- NVIDIA Ampere架构 - A100的核心是NVIDIA Ampere GPU架构,该架构包含超过540亿个晶体管,这使其成为全球最大的7纳米处理器。

---- 具有TF32的第三代Tensor Core核心 - NVIDIA广泛采用的Tensor Core核心现在已变得更加灵活、快速且易于使用。其功能经过扩展后加入了专为AI开发的全新TF32,它能在无需更改任何代码的情况下,使FP32精度下的AI性能提高多达20倍。此外,Tensor Core核心现在支持FP64精度,相比于前代,其为HPC应用所提供的计算力比之前提高了多达2.5倍。

--- 多实例GPU - MIG,一种全新技术功能,可将单个A100 GPU分割为多达七个独立的GPU,为不同规模的工作提供不同的计算力,以此实现最佳利用率和投资回报率的最大化。

--- 第三代NVIDIA NVLink - 使GPU之间的高速联接增加至原来的两倍,实现服务器的高效性能扩展。

--- 结构化稀疏 - 这种全新效率技术利用AI数学固有的稀疏性,使性能提升了一倍。

凭借这些新功能,NVIDIA A100成为了AI训练和推理以及科学模拟、对话式AI、推荐系统、基因组学、高性能数据分析、地震建模和金融预测等各种高要求工作负载的理想选择。

新系统已搭载NVIDIA A100,很快将登陆云端

于今日同时发布的还有NVIDIA DGX™ A100 系统,其内置8个由NVIDIA NVLink互联的NVIDIA A100 GPU。NVIDIA和官方合作伙伴现已开始供应该系统。

阿里云、AWS、百度智能云、Google Cloud、Microsoft Azure 、甲骨文和腾讯云正在计划提供基于A100的服务。

此外,众多全球领先的系统制造商也将提供各种基于A100的服务器,包括Atos、思科、Dell Technologies、富士通、技嘉科技、新华三、HPE、浪潮、联想、Quanta/QCT和Supermicro。

为帮助合作伙伴加快服务器的开发,NVIDIA开发了HGX A100服务器构建模块,该模块采用了多GPU配置的集成基板形式。

HGX A100 4-GPU通过NVLink实现GPU之间的完整互联, 8-GPU配置的HGX A100通过NVIDIA NVSwitch™实现GPU之间的全带宽通信。采用全新MIG 技术的HGX A100能够被分割为56个小型GPU,每个GPU的速度都比NVIDIA T4更快;或者也可以将其用作一台拥有10petaflops AI性能的巨型8-GPU服务器。

A100软件优化

NVIDIA还发布了多个软件堆栈更新,使应用程序开发者能够充分发挥A100 GPU创新技术的性能。这些更新包括了50多个新版本CUDA-X™ 库,可用于加速图形、模拟和AI;CUDA 11;多模态对话式AI服务框架NVIDIA Jarvis;深度推荐应用框架 NVIDIA Merlin;以及NVIDIA HPC SDK,其中包括能够帮助HPC开发者调试和优化A100代码的编译器、库和工具。

分享到微信

分享到微信

分享到微博

分享到微博