NVIDIA发布Microsoft Azure 云端可扩展型GPU加速超级计算机

2019-11-19 20:19

全新Microsoft Azure NDv2超大型实例可扩展至数百个互联的NVIDIA Tensor Core GPU,满足复杂的AI和高性能计算应用需求

NVIDIA于今日发布在Microsoft Azure云上的一种新型GPU加速超级计算机。

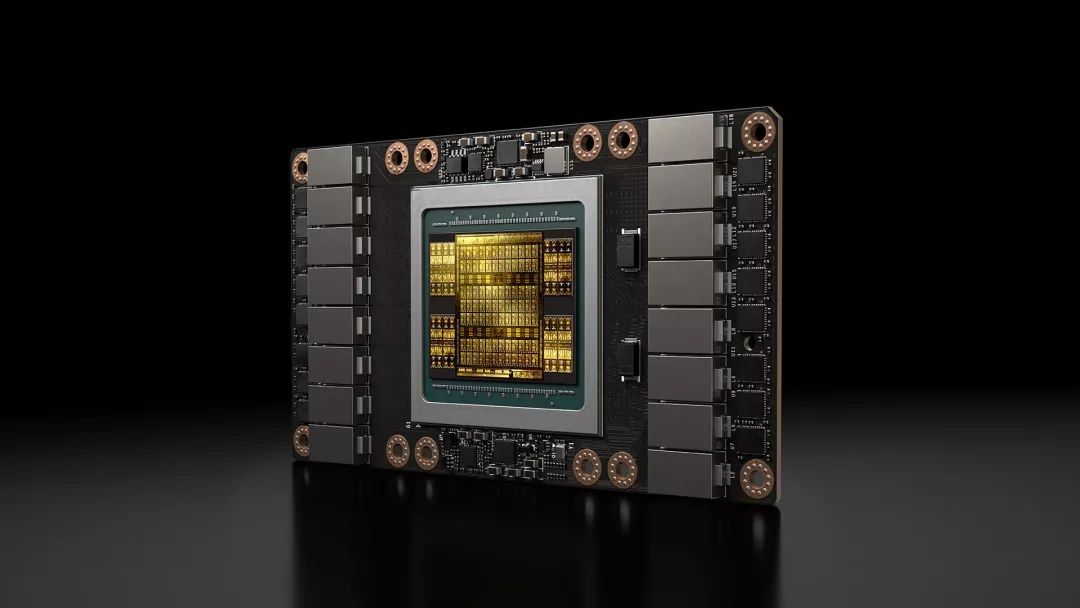

此次发布的全新NDv2实例是Azure上规模最大的一次部署,该产品专为处理要求苛刻的AI和高性能计算应用而设计,是全球速度最快的超级计算机之一。它能在一个Mellanox InfiniBand后端网络上提供多达800个互联的NVIDIA V100 Tensor Core GPU。这是首次用户可以根据需求,在自己的桌面上租用整台AI超级计算机,而且其性能与那些需要数个月时间才能完成部署的大型本地超级计算机相匹配。

NVIDIA副总裁兼加速计算总经理Ian Buck表示:“此前,只有一些全球性的大型企业和机构才能使用超级计算机进行AI和高性能计算。而这款在Microsoft Azure上推出的新产品实现了AI的大众化,使更多人能够获得基础工具,来解决一些全球最大的挑战。”

微软Azure Compute企业副总裁Girish Bablani补充说:“由于云计算在全球各地呈现增长趋势,客户正在寻求更高性能的服务。此次微软与NVIDIA的合作,能够让用户即时获取超级计算能力,这在以前是无法想象的。可以说,我们开创了一个创新的新时代。”

出色的性能和更高的性价比

这款新产品十分适用于复杂的AI、机器学习和高性能计算工作负载。相比基于CPU的传统计算,它具有显著的性能和成本优势。对于需要快速解决方案的AI研究人员来说,它可以快速启动多个NDv2实例,并在短短几小时内完成复杂的会话式AI模型的训练。

此前,微软和NVIDIA的工程师已在该集群的预览版本上使用64个NDv2实例进行了实验。他们用了约三小时完成了BERT会话式AI模型的训练。能够实现这一速度的原因之一是使用了NCCL(一款NVIDIA CUDA X™ 库)提供的多GPU优化以及高速Mellanox 互联解决方案。

另一个优点是客户可以使用多个NDv2实例运行复杂的高性能计算工作负载,比如LAMMPS,这是一种流行的分子动力学应用程序,用于在药物开发和探索等领域中模拟原子级物质。相比于一个专用于特定应用程序(如深度学习)的、未使用GPU的 HPC计算节点,单个NDv2实例就能实现高达一个数量级的速度提升。如果需要进行大规模的模拟,还可以将这一性能线性扩展至一百个实例。

所有NDv2实例都能够受益于NVIDIA NGC容器注册表和 Azure Marketplace中所提供的TensorFlow、PyTorch和MXNet等GPU优化高性能计算应用、机器学习软件及深度学习框架。该注册表还提供Helm图表,让用户在Kubernetes集群上可以轻松地部署AI软件。

供货

NDv2目前已推出预览版本。一个实例中包含8个NVIDIA V100 GPU,可组成集群,根据不同的工作负载需求进行扩展。

NVIDIA于今日发布在Microsoft Azure云上的一种新型GPU加速超级计算机。

此次发布的全新NDv2实例是Azure上规模最大的一次部署,该产品专为处理要求苛刻的AI和高性能计算应用而设计,是全球速度最快的超级计算机之一。它能在一个Mellanox InfiniBand后端网络上提供多达800个互联的NVIDIA V100 Tensor Core GPU。这是首次用户可以根据需求,在自己的桌面上租用整台AI超级计算机,而且其性能与那些需要数个月时间才能完成部署的大型本地超级计算机相匹配。

NVIDIA副总裁兼加速计算总经理Ian Buck表示:“此前,只有一些全球性的大型企业和机构才能使用超级计算机进行AI和高性能计算。而这款在Microsoft Azure上推出的新产品实现了AI的大众化,使更多人能够获得基础工具,来解决一些全球最大的挑战。”

微软Azure Compute企业副总裁Girish Bablani补充说:“由于云计算在全球各地呈现增长趋势,客户正在寻求更高性能的服务。此次微软与NVIDIA的合作,能够让用户即时获取超级计算能力,这在以前是无法想象的。可以说,我们开创了一个创新的新时代。”

出色的性能和更高的性价比

这款新产品十分适用于复杂的AI、机器学习和高性能计算工作负载。相比基于CPU的传统计算,它具有显著的性能和成本优势。对于需要快速解决方案的AI研究人员来说,它可以快速启动多个NDv2实例,并在短短几小时内完成复杂的会话式AI模型的训练。

此前,微软和NVIDIA的工程师已在该集群的预览版本上使用64个NDv2实例进行了实验。他们用了约三小时完成了BERT会话式AI模型的训练。能够实现这一速度的原因之一是使用了NCCL(一款NVIDIA CUDA X™ 库)提供的多GPU优化以及高速Mellanox 互联解决方案。

另一个优点是客户可以使用多个NDv2实例运行复杂的高性能计算工作负载,比如LAMMPS,这是一种流行的分子动力学应用程序,用于在药物开发和探索等领域中模拟原子级物质。相比于一个专用于特定应用程序(如深度学习)的、未使用GPU的 HPC计算节点,单个NDv2实例就能实现高达一个数量级的速度提升。如果需要进行大规模的模拟,还可以将这一性能线性扩展至一百个实例。

所有NDv2实例都能够受益于NVIDIA NGC容器注册表和 Azure Marketplace中所提供的TensorFlow、PyTorch和MXNet等GPU优化高性能计算应用、机器学习软件及深度学习框架。该注册表还提供Helm图表,让用户在Kubernetes集群上可以轻松地部署AI软件。

供货

NDv2目前已推出预览版本。一个实例中包含8个NVIDIA V100 GPU,可组成集群,根据不同的工作负载需求进行扩展。

分享到微信

分享到微信

分享到微博

分享到微博